Почему Яндекс не индексирует страницы сайта?

Почему Яндекс не индексирует страницы?

Однажды я рассказывал об инструменте «Проверить URL» от Яндекса. С его помощью можно узнать о «взаимоотношениях» поискового робота и конкретной страницы вашего сайта.

Сейчас же опишу, как можно более нацеленно использовать данный инструмент, а именно — чтобы узнать причины неиндексации страницы Яндексом.

Иногда не ясно, что не так со страницей и почему она не лезет в индекс. Если и у вас бывают подобные вопросы, то используйте следующий подход.

Почему Яндекс может не индексировать страницу?

Сначала зайдём в интерфейс инструмента «Проверить URL». Для этого в Яндекс.Вебмастере выбираем нужный сайт для проверки и на открывшейся странице слева кликаем на «Проверить URL»:

Меню слева

На новой странице будет поле для ввода URL — сюда и вводим «проблемные» адреса. Все введённые адреса будут отображены ниже:

Инструмент проверки URL в Яндекс.Вебмастере

Затем кликаем на «готово» — и тут самое интересное.

Если выдаёт такое

Всё Ok

значит, всё хорошо (это, кстати, ещё один способ проверки индексации страниц).

Если такое

Тоже Ok

— тоже нормально. В этом случае может помочь приём ускорения индексации.

Ну а если же такое

Не хочет индексировать

то в этом случае Яндекс не хочет индексировать данную страницу сайта, т.к. считает её некачественной (о чём и написано в Помощи).

Сложно точно сказать, почему робот не хочет индексировать ту или иную страницу. Например, для проверяемого сайта проблемными оказались страницы как с малым содержанием контента, так и со средним; как с действительно малополезным содержанием, так и с полезным (на мой взгляд).

Что делать?

Если

но Яндекс всё равно не индексирует страницу, то решение тут универсальное — следует увеличивать ценность контента для посетителей ![]()

![]()

Loading…

Loading…

Google и Яндекс не индексируют сайт: причины, руководство что делать

Форумы вебмастеров пестрят грустными постами по поводу того, что сайт плохо индексируется поисковыми системами. А ведь это основа SEO-продвижения, без которой популяризация интернет-ресурса практически невозможна.

Обидней всего, когда над созданием web-проекта трудился дорогостоящий программист, а на его наполнение контентом ежемесячно тратится внушительная сумма.

Однако Яндекс и Гугл не спешат индексировать отдельные страницы или даже целый сайт. Почему так происходит?

На этот вопрос нет однозначного ответа: существует множество причин.

Важно выявить конкретную проблему (технические ошибки, дубляж страниц, нестабильную работу хостинга или санкции поисковиков) и сделать все для ее решения. Есть хорошая новость — ситуацию можно исправить. Хотите, знать как? Читайте дальше!

Нормы индексации сайтов

В Яндекс

Yandex сканирует и добавляет новые страницы примерно два-четыре раза в месяц. Попасть в поисковую выдачу раньше способны лишь трастовые и часто обновляемые порталы — внушающие доверие сайты индексируются быстроботом Яндекса ежедневно.

В Google

Что касается Гугла, обновления могут занять от одного дня до двух недель. Здесь многое зависит от категории вашего сайта. Например, ресурсы с актуальными новостями и живые форумы роботы проверяют с завидной регулярностью.

Материалы часто обновляемых порталов обычно сканируются в тот же день или на следующий. Индексация блога, в котором каждую неделю появляется новый контент, нередко задерживается на 2–4 дня.

Совсем печально обстоит дело с третьесортными сайтами, а также совсем молодыми веб-проектами, только что появившимися в Сети. Поисковые роботы могут игнорировать их в течение месяца.

Важно! Вышеописанные данные актуальны при добавлении малого количества страниц в индекс. При добавлении большого количества страниц одномоментно, скорость индексации может увеличиться в несколько раз.

Особенно долго будут индексироваться страницы с малой ценностью для посетителей.

Что делать, если новый сайт не индексируется поисковиками?

Под это определение подходит ресурс с возрастом домена до полугода, который не имеет обратных ссылок и ранее не продвигался.

Добавить сайт в панели вебмастеров

Вы только что создали сайт и ждете чуда под названием «быстрая индексация»? Такая стратегия ошибочная, ведь в первое время Гугл и Яндекс не обращают на новый сайт внимание. Помогите своему проекту заинтересовать роботов — сделать это достаточно просто: надо лишь добавить сайт в поисковые системы.

Важно! Использование сервиса Яндекс. Вебмастер и Google Webmaster не только ускорит добавление страниц в индекс, но и позволит эффективнее работать над оптимизацией сайта. Представленные инструменты бесплатно открывают вебмастерам множество возможностей для диагностики, получения рекомендованных для продвижения запросов и привязки сайта к конкретному региону.

Улучшить сайт

Пора заняться внутренней оптимизацией: систематически создавать первоклассный контент, улучшить юзабилити, сделав удобные рубрики, а также позаботиться об адаптивности и перелинковке. После этого следует задуматься о внешнем продвижении. Оно включает в себя работу с социальными факторами и размещение естественных ссылок у надежных доноров.

Если сайт все так же не индексируется Яндексом, необходимо написать в техническую поддержку поисковика. В результате вашего запроса вы получите информацию о наличии бана, фильтра или установите другую объективную причину возникшей проблемы.

Как проверить индексацию сайта?

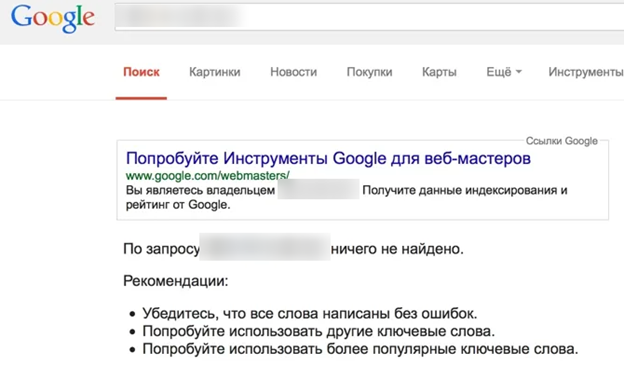

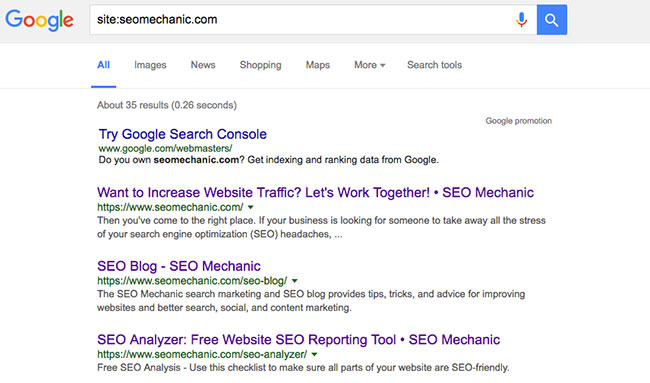

Используйте в запросе оператор Site

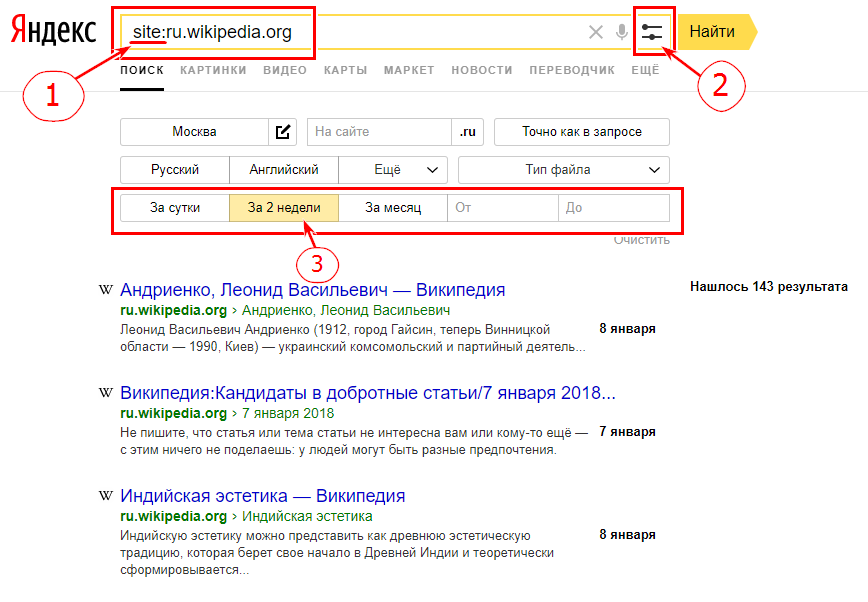

Узнайте количество просканированных и добавленных в индекс страниц путем введения в строку поиска Гугл и Яндекс «site: url вашего сайта». Благодаря дополнительным настройкам легко получить данные о произошедших за конкретный промежуток времени изменения.

К примеру, сегодняшняя проверка российской версии Википедии показала, что за последние 2 недели на этом сайте появилось 143 новых материалов.

Учтите! Разница между показателями разных поисковых систем является поводом для тревоги. Чаще всего это свидетельствует о возможном попадании под фильтр Гугла или Яндекса.

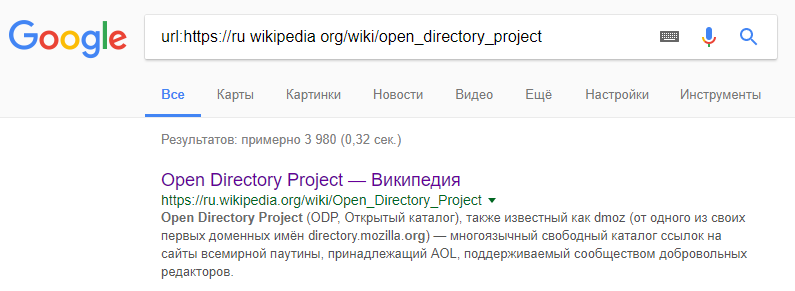

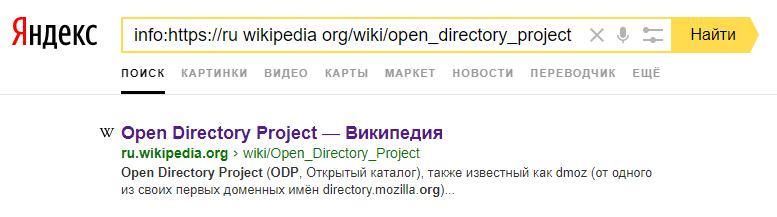

Введите в поисковик url страницы

Этот способ идеален для проверки индексации отдельно выбранной страницы.

Для Google

url:https://ru.wikipedia.org/

Для Яндекс

info:https://ru.wikipedia.org/

Через панель вебмастеров

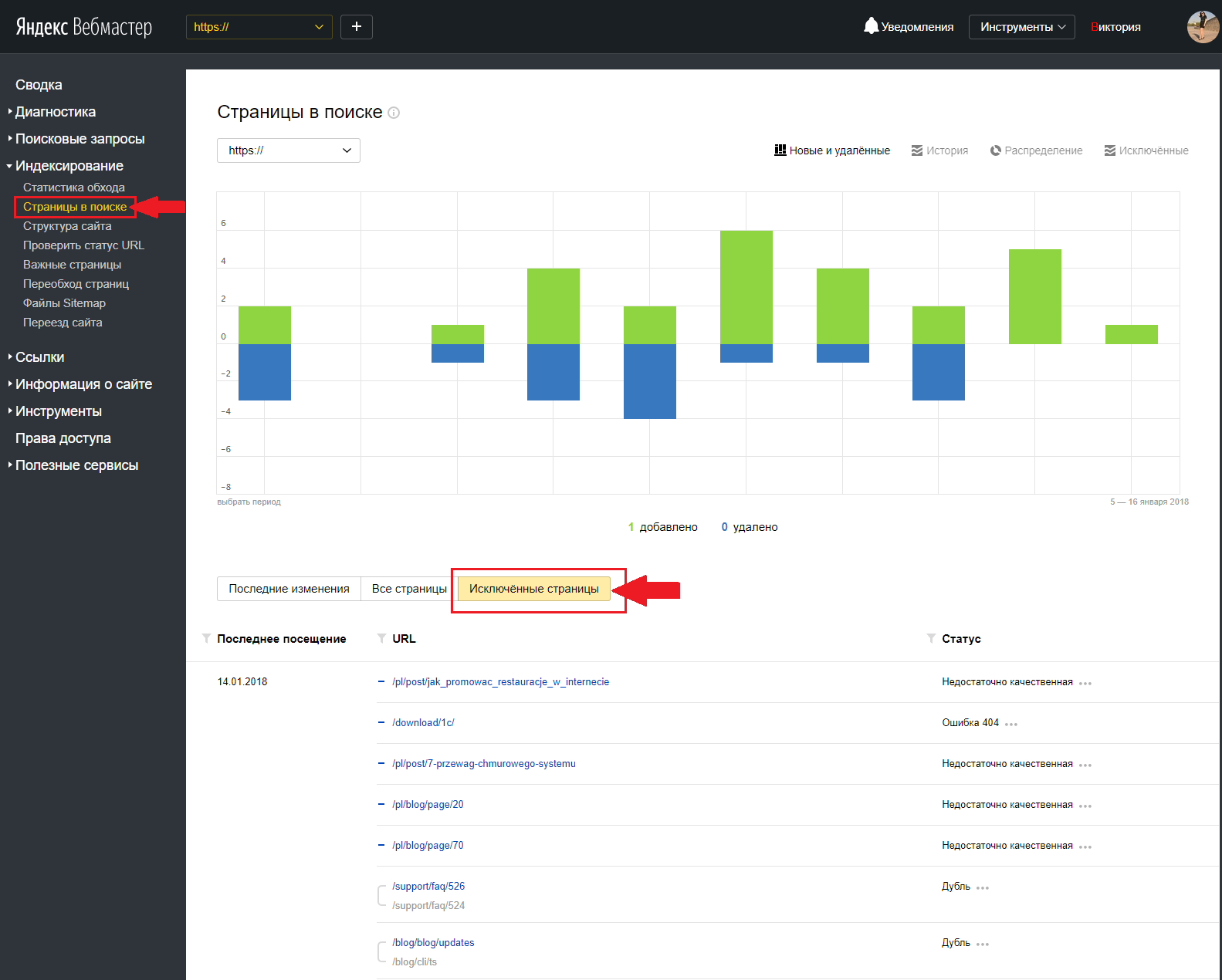

Если вы ранее уже зарегистрировались в Яндекс. Вебмастер, то при переходе на данный сервис сразу увидите число загруженных материалов и тех, что находятся в поиске. В идеале их количество должно совпадать или быть похожим на реальное количество страниц сайта.

Более детальную информацию вы получите при переходе на основную панель, после чего необходимо нажать «Индексирование» и «Страницы в поиске».

Анализируя полученный отчет и ищите страницы, которые не индексируются.

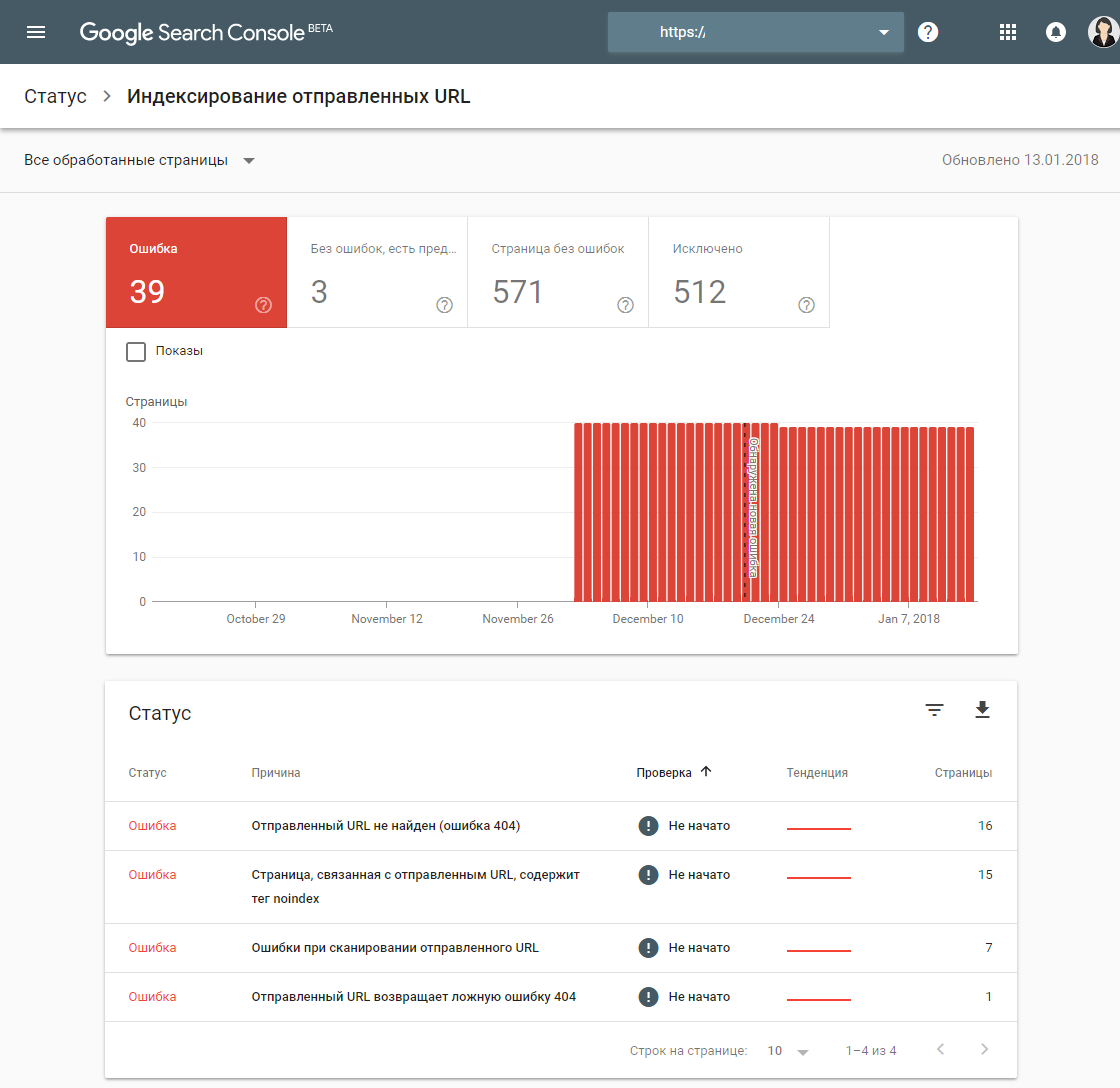

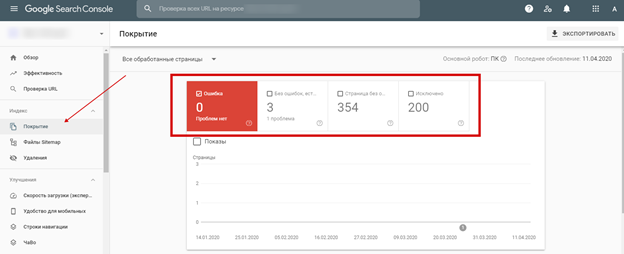

В новом Google вебмастере также есть инструмент для анализа индексации.

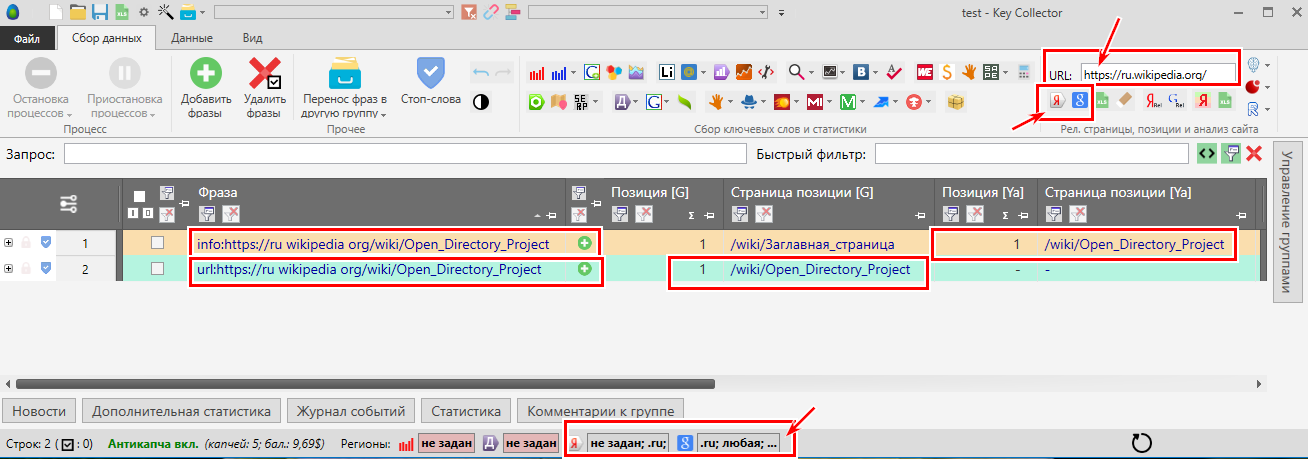

С помощью Key Collector проверяем индексацию большого количества страниц

Скачанный и установленный на компьютере многофункциональный инструмент облегчит работу любому оптимизатору. Он позволяет автоматизировать процесс, значит, вам не придется вручную проверять сотни, а то и тысячи документов.

Чтобы воспользоваться этим методом, требуется собрать парсером список всех страниц, а затем добавить перед каждым адресом оператор url для Google или info для Яндекс. Хотите сэкономить время и нервы — воспользуйтесь для этого автозаменой в блокноте. Дальше надо загрузить полученные данные в Key Collector, не забыв о настройке XML для быстрого анализа результатов.

Также, нужно настроить правильно поисковые системы, для корректного парсинга. URL лучше добавлять без смены регистра.

У проиндексированных материалов в графе «Позиция по запросу» будет стоять единица. Сверьте ваш URL со страницей на первом месте. Они должны совпадать.

Это метод не идеален, но имеет право жизнь.

Как решить проблемы индексации?

Вариант 1: Сайт долго не индексируется, роботы не видят свежие материалы — в индекс попадает мало новых страниц, процесс осуществляется медленно.

Узнайте далее, что может быть причиной столь плачевной ситуации.

Редкое обновление контента

Для SEO-продвижения нужно вовремя подкармливать роботов новой порцией качественного контента, тогда они будут чаще заходить на ваш сайт. Причем на поведение поисковиков положительно влияют даже незначительные улучшения старых статей в виде более удачных иллюстраций, обновлений даты публикации или добавления цитаты эксперта.

А вот если робот приходит и видит, что за период его последнего посещения ничего не изменилось, сайт не будет нормально индексироваться в будущем. Более того, ждите ухудшения позиций в выдаче: ресурс, остановившийся в развитии, опережают конкуренты.

То есть

Если вы публикуете не регулярно — это может быть причиной. Если это не ваша ситуация, то читайте далее.

Плохое качество контента

За последние годы и читатели, и роботы стали более требовательными к размещенной в Рунете информации. Важную роль играет не только техническая, но и смысловая уникальность / полнота статей, картинок, видео.

При этом ключевые слова должны вписываться в текст естественно, а за переспам есть шанс попадания под фильтры поисковиков.

То есть

Если публикуемый контент малополезен или состоит из 100 слов, то вряд ли он попадет в индекс. Необходимо менять подход к написанию контента или качеству страниц.

Заинтересованы в генерации отличного контента?

Возьмите на вооружение LSI-копирайтинг, который сейчас в почете у поисковых систем. При качественном оформлении, полном раскрытии темы с использованием ключей и списка дополнительных синонимов, ассоциаций вам не придется беспокоиться о том, что страница не будет индексироваться в поисковых системах.

Наличие дубликатов

Секретом успешной технической оптимизации является отсутствие одинаковых мета-тегов и текстов; полных копий страниц. Если таковые имеются, закройте лишние данные от индекса при помощи meta name=«robots» content=«noindex, nofollow» или пропишите на них 301 редирект.

В противном случае поисковики запутаются в похожих документах и удалят их из выдачи.

Проблемы с краулинговым бюджетом

Существует определенный лимит на количество страниц, индексируемых роботом за единицу времени.

Краулинговый бюджет Google напрямую зависит от PageRank ресурса. Чем выше данный показатель, тем большее число документов будет проиндексировано. Соответственно, для масштабных сайтов крайне важно повышать критерий своей ценности путем регулярных обновлений, увеличения посещаемости и приобретения ссылок. Иначе некоторые страницы могут не индексироваться в Гугле.

То есть

Если сайт молодой, то у него низкий краулинговый бюджет. И если вы хотите проиндексировать большое количество страниц, то эта процедура может занять на порядок больше времени.

Технические нюансы для ускорения сканирования

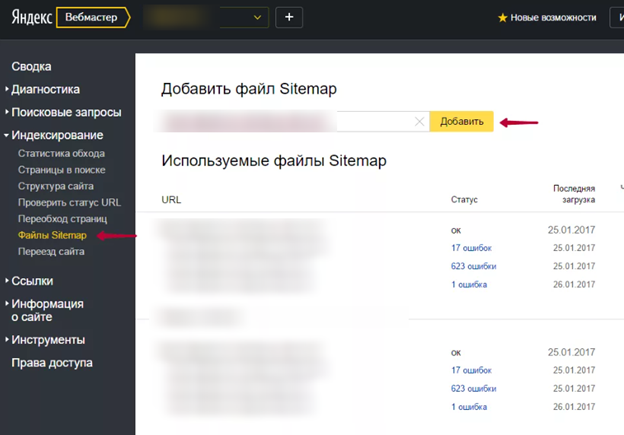

Добавление sitemap.xml

Эта карта, созданная для поисковых систем, дает роботам возможность быстро найти все страницы, независимо от их числа и уровней вложенности. Кроме того, она повышает доверие к вашему сайту, позволяет указывать дату обновления и расставлять приоритеты.

Алгоритм действий следующий: сгенерируйте sitemap.xml с учетом стратегии продвижения, загрузите карту в корень сайта и добавьте в панели вебмастеров.

Обновление http-заголовков Last-Modified и If-Modified-Since.

Last-Modified сообщает поисковикам о последних изменениях в документе, направляя роботов сразу к обновленным страницам и свежим материалам.

Ответ сервера на запрос If-Modified-Since снижает нагрузку на краулинговый бюджет, к тому же улучшает позиции контента при сортировке по дате.

Проверить этот заголовок можно тут — https://last-modified.com/ru/if-modified-since.html

Вариант 2: Сайт вообще не индексируется в Яндексе и Гугле, страницы выпадают из индекса.

Код ответа сервера

Убедитесь, что страница содержит код сервера 200 ОК — это означает: она действительно существует, доступна к просмотру для пользователей и поисковых систем.

Проверка осуществляется при помощи специальных сервисов.

Например, http://www.bertal.ru/index.php?a1910327/

Если код ответа не 200 ОК, то именно в этом может быть причина не индексации страницы.

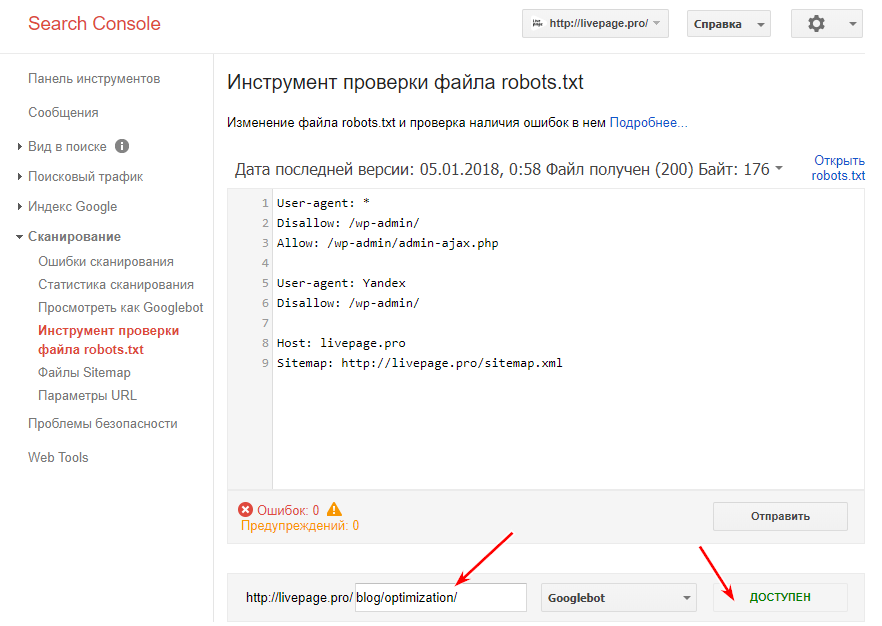

Robots.txt

В файле robots.txt недопустимы запреты на индексацию сайта и отдельных страниц, а также работу конкретного поисковика.

Важно! Обязательно проверьте сформированный robots.txt на ошибки. Сделать это можно в Google Вебмастер: нажмите на «Сканирование», а затем на «Инструмент проверки файла robots.txt».

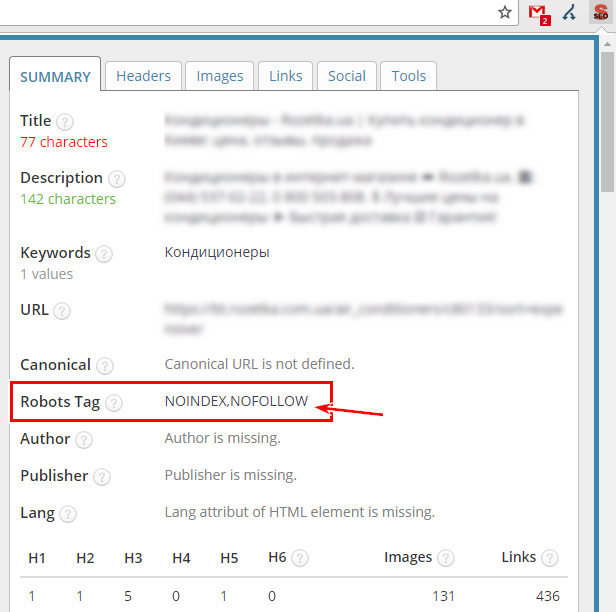

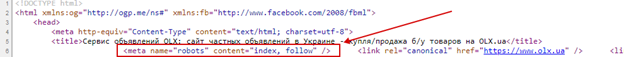

Meta Robots

Часто сайт не индексируется в Гугле, если добавление сведений в базу данных запрещено в мета-тегах. Обязательно удалите в HTML-коде строкии если они есть на важных страницах.

Чтобы проверить откройте код страницы и сделайте поиск строки.

Либо используйте плагины для браузера, такие как расширение Seo Meta in 1 Click для Google Chrome.

Rel Canonical

Многие неопытные оптимизаторы неверно настраивают атрибут rel=canonical.

Хотите, чтобы страница попала в индекс поисковика? Тогда она не должна ссылаться на другой канонический документ.

Чтобы проверить откройте код страницы и сделайте поиск строки.

Либо через тот же плагин

Вебмастера

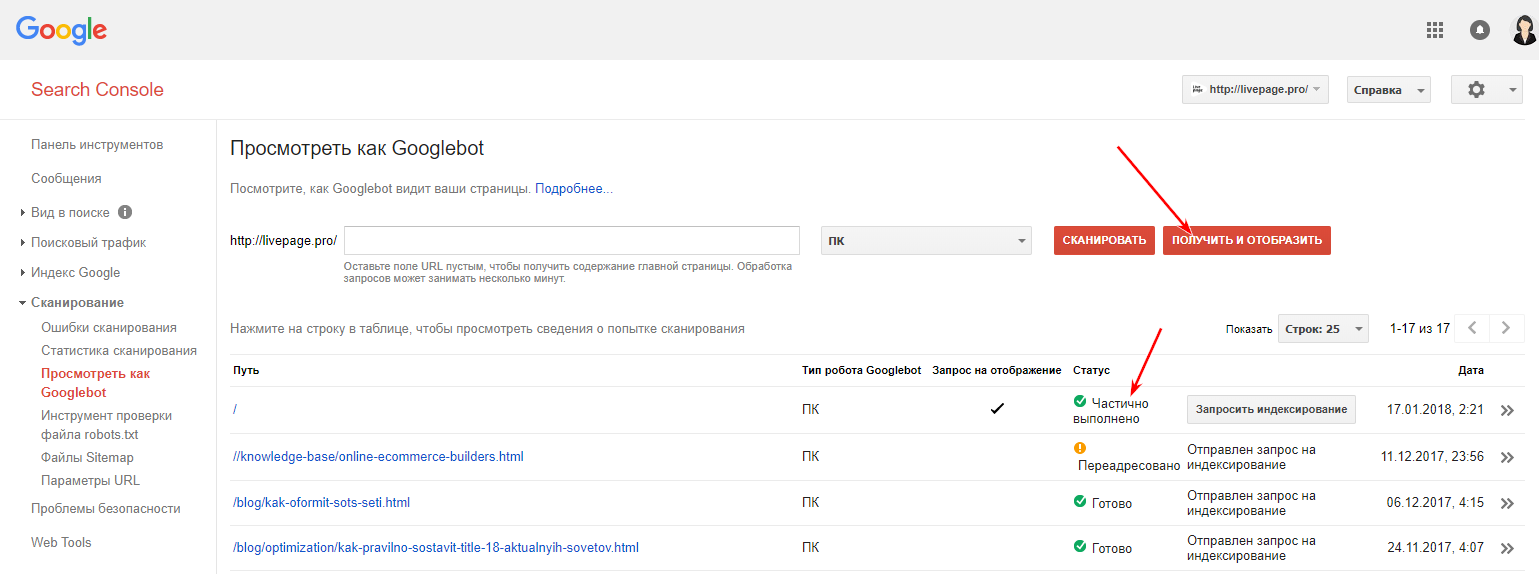

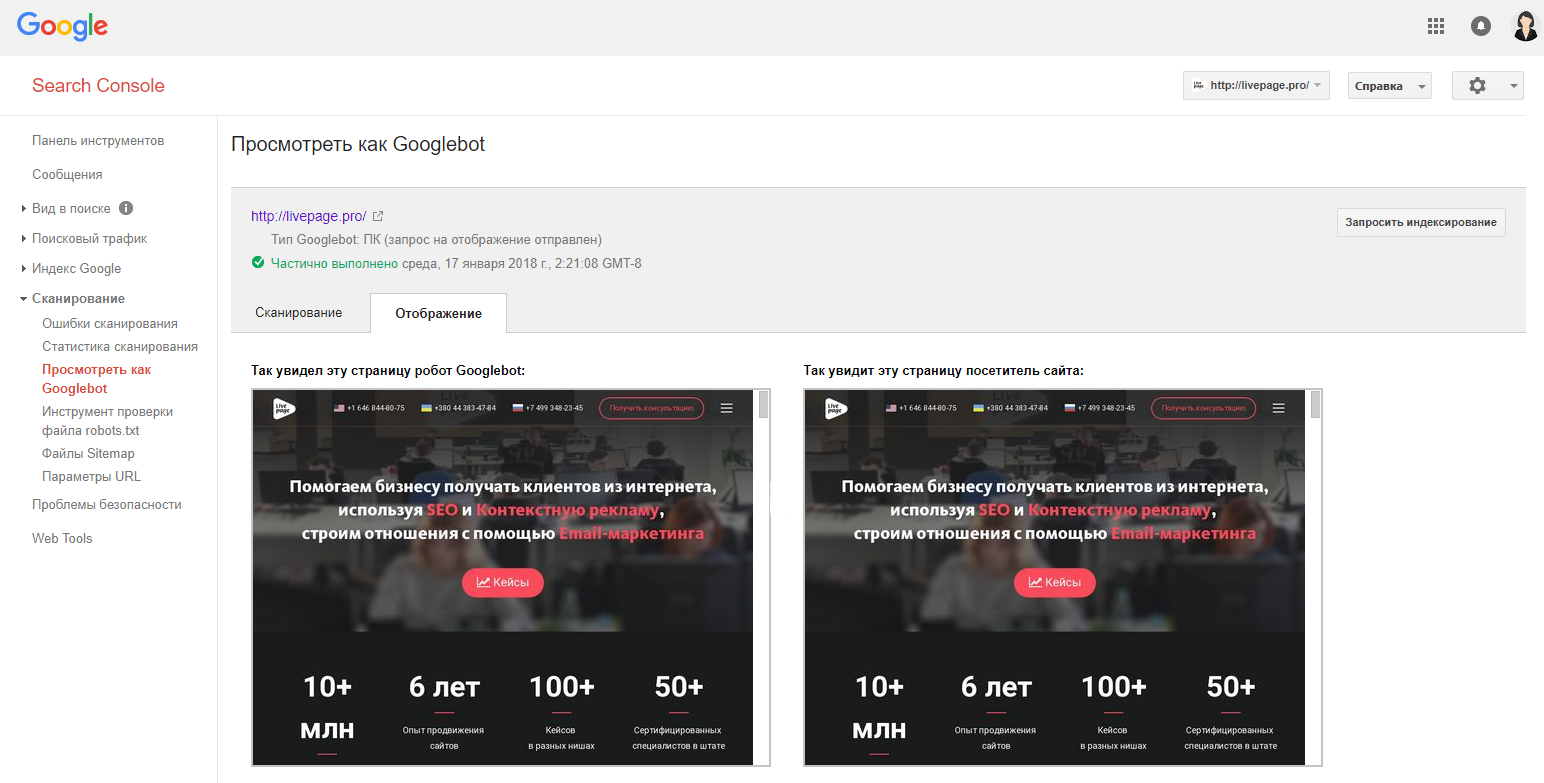

Используйте Google Webmaster Tools для выявления ошибок сканирования, из-за которых роботы не получают ответы на запросы.

Перейдите в раздел «Просмотреть как Googlebot» введите адрес страницы, и нажмите кнопку «Получить и отобразить».

Когда получите результат, сравните, что видит Google и пользователь. Картинки должны быть одинаковыми. Если нет, то ищите причины блокировки файлов.

Протестируйте скорость загрузки и время ответа сервера. Убедитесь, что выбранный вами хостинг работает стабильно.

Файл .htaccess

Если сайт не индексируется, он может быть заблокирован в файле .htaccess.

Проверьте .htaccess на наличие таких строк:

RewriteCond %{USER_AGENT} Googlebot

RewriteRule.* — [F]

Либо такой вариант, который будет отдавать роботу Google 404 ошибки.

RewriteCond %{USER_AGENT} Googlebot

RewriteRule.* — [R=404]

Поищите в файле другие варианты блокировок с использованием USER_AGENT или названия поисковых ботов: googlebot, yandex и т. д.

AJAX и JavaScript

Распространены проблемы с языками AJAX и JavaScript. Блог Яндекса для вебмастеров рекомендует создать в структуре ресурса определенную схему, которая сообщит поисковым системам о необходимости индексации.

Санкции

Еще одна серьезная проблема — наложение санкций на страницу или даже весь сайт. Узнайте в техподдержке поисковой системы (только Яндекс), за что именно (ссылки, переспам, неуникальный контент) вас наказали, после чего оперативно исправьте ситуацию.

Как уже говорилось ранее, причиной отсутствия внимания к странице часто является низкокачественный и дублированный контент.

Вряд ли робот будет заинтересован в ваших материалах, если в выдаче уже имеются похожие документы, продвигаемые по тому же семантическому ядру.

Негативно влияет на скорость индексирования незрелый возраст домена, а также забаненный ранее б/у домен. В таком случае стоит написать запрос на пересмотр в Яндекс.

Итоги

Если сайт не индексируется Яндексом или Гуглом, значит, на то есть объективная причина. Ваша цель — выявить и решить проблему. Спустя некоторое время необходимо снова проверить индексацию страницы. Если вы все сделаете правильно, положительные изменения не заставят себя долго ждать!

Если у вас сложный случай, рекомендую обратиться за консультацией к специалистам. Команда Livepage проконсультирует и выполнит SEO-аудит, который решит все проблемы с индексацией в поисковых системах.

16 причин почему сайт не индексируется в Яндекс и Google

Многие вебмастера сталкиваются с проблемами индексации сайта, которые негативно влияют на его SEO-продвижение, трафик. Они постоянно совершенствуют сайт, оптимизируют, добавляют новый контент, а число страниц в индексе не растет, либо и вовсе весь ресурса там отсутствует.

Чтобы предпринять соответствующие меры по предотвращению данной проблемы, нужно выяснить, почему сайт не индексируется поисковыми роботами. Сегодня мы и поговорим об основных причинах, которые приводят к тому, что материалы с ресурса не вносятся в базу данных поисковиков.

1. Яндекс и Google еще не заметили ваш ресурс

Это одна из самых возможных причин. Вы недавно создали свой сайт и выложили его в интернет, но не предприняли никаких мер, чтобы поисковики побыстрее нашли его. Тогда индексацию и вправду можно ждать очень долго.

Чтобы этого не допустить, обязательно добавьте проект в Addurl (Аддурилку), а также в панель вебмастера Google и Яндекс. Проделав эти несложные шаги, можно ожидать попадания сайта в индекс уже через пару часов, но бывает, что приходится ждать и несколько дней.

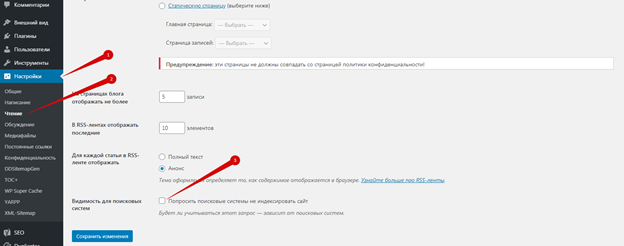

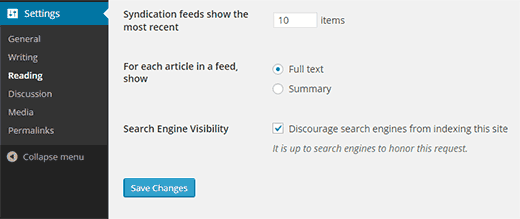

2. Настройки приватности в WordPress

Если вы используете готовую CMS, обязательно проверьте приватные настройки, которые нередко установлены по умолчанию, и именно из-за них сайт может не индексироваться.

Например, если у вас WordPress зайдите в «Настройки», а затем в «Чтение». Там вы найдете опцию «Видимость для поисковиков», напротив которого нужно убрать галочку возле «Попросить поисковые машины не индексировать сайт».

Если вы используете другую CMS, то обязательно проверьте стоит ли у вас в настройках подобная опция. Как ни странно, но ситуации, когда сайтостроители элементарно забывают снять эту галочку, случаются довольно регулярно.

3. Веб-ресурс или отдельные его файлы заблокированы в robots.txt

Еще одна распространенная причина, которая остается без внимания вебмастеров. Но и эту проблему легко исправить. Если на сайте нет мусорных страниц и технических разделов, то достаточно создать файл robots с таким правилом, которое разрешает индексировать весь ваш сайт:

User-agent: * Disallow:

Что такое robots.txt и как правильно его настроить читайте в этой статье.

4. На сайте много повторяющихся материалов

Как правило, зачастую дублируются страницы и мета-теги. Это грозит не только непопаданием вашего сайта в индекс, но и применением по отношению к нему санкций от Google Panda (алгоритм, который борется с некачественным контентом). Узнать, какие основные проблемы существенно снижают качество и эффективность проекта, вы можете в разделе «Вид в поиске» –> «Оптимизация HTML» в Google Вебмастере.

Сегодня это одна из распространенных причин, по которой сайты попадают под санкции, и разработчикам становится сложнее их продвигать.

5. Мета-тег name, content

Скрыть веб-ресурс от поисковиков можно и мета-тегом:

<meta name=”robots” content=”noindex, nofollow”>

Иногда это правило может быть прописано и для определенных роботов:

<meta name="googlebot" content="noindex" />

Чтобы проверить его наличие, откройте исходный код сайта и проверьте содержимое. Если найдете вышеупомянутую строку, просто удалите ее, или «nofollow» и «noindex» замените на «follow» и «index» соответственно.

Да, бывали и такие случаи, когда данный мета-тег присутствовал в коде, а вебмастера даже не догадывались об этом и искали совершенно другие проблемы.

6. Мета-тег noindex

Заодно проверьте в коде тег <noindex></noindex>, не обрамлен ли им ваш контент. Этот тег служит для поисковой системы Яндекс, который указывает, что этот контент не следует индексировать. То есть если у вас часть текста закрыта этим тегом, то у вас страница будет индексироваться, а сам контент который им обрамлен не будет.

7. Использование HTTP-заголовка X-Robots-Tag

Этот способ закрывает от индексации страницы только для Google. В коде этот метатег не найти, так как он работает на уровне заголовков сервера. Проверить его можно с помощью плагина для браузера Web Developer: Chrome, FireFox

Или с помощью онлайн инструмента http://tools.seobook.com/server-header-checker/

8. Перебои в работе хостинга или сервера

Если робот посетил ваш сайт, чтобы проиндексировать его содержимое, а в это время он оказался недоступным, то страницы так и не будут внесены в базу данных поисковых систем. Поэтому очень важно выбрать надежный хостинг и сервер с хорошим up time.

Чтобы всегда быть в курсе доступности ресурса, созданы самые разные сервисы. Найти их можно, введя в поиск запрос «uptime checker». Рекомендуем Яндекс.Метрика – он совершенно бесплатный.

9. Ошибки при сканировании

Если их возникает в изобилии, то боты не имеют возможности полноценно обойти сайт и добраться до необходимых страниц. Проверить наличие ошибок можно в Google Webmaster Tools. Зайдите в раздел «Сканирование» и выберите «Ошибки сканирования». Если они будут обнаружены, сервис предложит их исправить.

10. Ранее используемый домен

Если вы зарегистрировали сайт на старое доменное имя, потому что оно легко читается и хорошо звучит, будьте готовы к тому, что его предыдущий владелец занимался черными методами SEO-продвижения, и теперь вам придется «разгребать» все те проблемы, к которым привела его деятельность.

Поправить ситуацию можно:

- Отправив в Яндекс и Google запрос на пересмотр и узнав, почему страницы не индексируются.

- Продолжая продвигать проект и работать над его качеством.

На заметку. Если домен спустя 3 или чуть более месяцев все равно нормально не индексируется, лучше сменить доменное имя. Или написать в поддержку поисковых систем и узнать насчет санкций на этот домен.

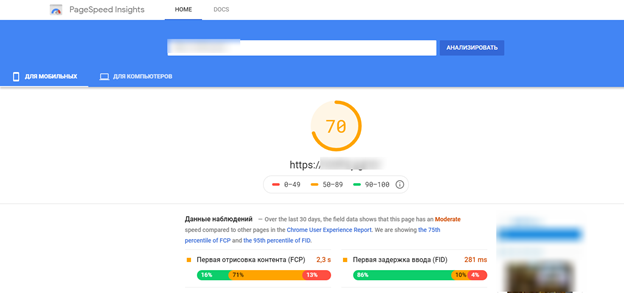

11. Медленная скорость загрузки сайта

Данный показатель является одним из основных факторов ранжирования ресурса и оказывает существенное влияние на его позиции в поисковых системах. Разумеется, если ваш портал загружается дольше положенного, с большой долей вероятности и его индексация будет проходить очень медленно. Самое оптимальное время загрузки составляет 2 секунды. Более 3-х секунд – это уже долго. На загрузку сайта влияет хостинг на котором он расположен.

12. Ресурс заблокирован в файле htaccess

Зачастую данный файл используется для настройки 301 редиректа, однако здесь также можно осуществить закрытие поисковым ботам доступ к сайту. Чтобы проверить содержимое .htaccess, найдите его на сервере, после чего проверьте код, чтобы там не было команды, блокирующей ресурс.

13. Наличие AJAX и JavaScript

Поисковик Google индексирует их, но гораздо сложнее, чем тот же HTML. Неправильно настроив страницы AJAX и JavaScript, ваш сайт не будет проиндексирован.

14. Попадание под фильтры поисковиков

Получить Deindexed, пожалуй, страшнее всего. Это наказание за то, что вебмастер выбрал нелегальную политику продвижения своего сайта: размещал запрещенные материалы или нерелевантный запросам контент, спамил ключевыми словами, использовал дорвеи и пр. Это очень и очень плохо, и если вас разоблачили, то вернуть сайт в поиск и заслужить доверие поисковых машин будет сложно.

15. Индексация сайта с www и без www

По сути, www – это поддомен. Поэтому https://imajor.ru и https://www.imajor.ru – это разные адреса сайта. Перепроверьте, указали вы 301 редирект с одного домена на другой. Также не забудьте указать основное доменное имя, и при этом подтвердить, что вы являетесь владельцем обеих доменов, чтобы поисковая система не считала эти домены разными сайтами.

16. Отсутствие карты сайта

В редких случаях, но отсутствие Sitemap на сайте может стать причиной того, что он остается незамеченным поисковыми ботами. Эту страницу тоже не забудьте добавить в панель вебмастера Яндекс и Google.

Заключение

Без индексации веб-сайта его существование просто бессмысленно, только если вы не ведете его чисто для себя. Если желаете продвигать сайт, найдите причину, из-за которой он не заносится в индекс. Это важно, чтобы поскорее предотвратить проблему и в дальнейшем не допускать ее снова.

Если же вы исправили все вышеуказанные причины и ресурс все-равно не попадает в поиск, незамедлительно обращайтесь в поддержку Google и Яндекс. Там вам с большой вероятностью объяснят, в чем дело.

5 способов закрыть сайт от индексации в Google и Яндекс

Очень часто требуется закрыть сайт от индексации, например при его разработке, чтобы ненужная информация не попала в индекс поисковых систем или по другим причинам. При этом есть множество способов, как это можно сделать, все их мы и рассмотрим в этой статье.

Зачем сайт закрывают для индекса?

Есть несколько причин, которые заставляют вебмастеров скрывать свои проекты от поисковых роботов. Зачастую к такой процедуре они прибегают в двух случаях:

- Когда только создали блог и меняют на нем интерфейс, навигацию и прочие параметры, наполняют его различными материалами. Разумеется, веб-ресурс и контент, содержащийся на нем, будет не таким, каким бы вы хотели его видеть в конечном итоге. Естественно, пока сайт не доработан, разумно будет закрыть его от индексации Яндекса и Google, чтобы эти мусорные страницы не попадали в индекс.

Не думайте, что если ваш ресурс только появился на свет и вы не отправили поисковикам ссылки для его индексации, то они его не заметят. Роботы помимо ссылок учитывают еще и ваши посещения через браузер.

- Иногда разработчикам требуется поставить вторую версию сайта, аналог основной на которой они тестируют доработки, эту версию с дубликатом сайта лучше тоже закрывать от индексации, чтобы она не смогла навредить основному проекту и не ввести поисковые системы в заблуждение.

- Когда только создали блог и меняют на нем интерфейс, навигацию и прочие параметры, наполняют его различными материалами. Разумеется, веб-ресурс и контент, содержащийся на нем, будет не таким, каким бы вы хотели его видеть в конечном итоге. Естественно, пока сайт не доработан, разумно будет закрыть его от индексации Яндекса и Google, чтобы эти мусорные страницы не попадали в индекс.

Какие есть способы запрета индексации сайта?

- Панель инструментов в WordPress.

- Изменения в файле robots.txt.

- Посредством мета-тега name=“robots”

- Написание кода в настройках сервера.

1. Закрытие индексации через WordPress

Если сайт создан на базе WordPress, это ваш вариант. Скрыть проект от ботов таким образом проще и быстрее всего:

- Перейдите в «Панель управления».

- Затем в «Настройки».

- А после – в «Чтение».

- Отыщите меню «Видимость для поисковиков».

- Возле строки «Рекомендовать поисковым роботам не индексировать сайт» поставьте галочку.

- Сохраните изменения.

Благодаря встроенной функции, движок автоматически изменит robots.txt, откорректировав правила и отключив тем самым индексацию ресурса.

На заметку. Следует отметить, что окончательное решение, включать сайт в индекс или нет, остается за поисковиками, и ниже можно увидеть это предупреждение. Как показывает практика, с Яндексом проблем не возникает, а вот Google может продолжить индексировать документы.

2. Посредством файла robots.txt

Если у вас нет возможности проделать эту операцию в WordPress или у вас стоит другой движок сайта, удалить веб-сайт из поисковиков можно вручную. Это также реализуется несложно. Создайте обычный текстовый документ, разумеется, в формате txt, и назовите его robots.

Затем скиньте его в корневую папку своего портала, чтобы этот файл мог открываться по такому пути site.ru/robots.txt

Но сейчас он у вас пустой, поэтому в нем потребуется прописать соответствующие команды, которые позволят закрыть сайт от индексации полностью или только определенные его элементы. Рассмотрим все варианты, которые вам могут пригодиться.

Закрыть сайта полностью для всех поисковых систем

Укажите в robots.txt команду:

User-agent: * Disallow: /

Это позволит запретить ботам всех поисковиков обрабатывать и вносить в базу данных всю информацию, находящуюся на вашем веб-ресурсе. Проверить документ robots.txt, как мы уже говорили, можно, введя в адресной строке браузера: Название__вашего_домена.ru/robots.txt. Если вы все сделали правильно, то увидите все, что указано в файле. Но если, перейдя по указанному адресу, вам выдаст ошибку 404, то, скорее всего, вы скинули файл не туда.

Отдельную папку

User-agent: * Disallow: /folder/

Так вы скроете все файлы, находящиеся в указанной папке.

Только в Яндексе

User-agent: Yandex Disallow: /

Чтобы перепроверить, получилось ли у вас удалить свой блог из Яндекса, добавьте его в Яндекс.Вебмастер, после чего зайдите в соответствующий раздел по ссылке https://webmaster.yandex.ru/tools/robotstxt/. В поле для проверки URL вставьте несколько ссылок на документы ресурса, и нажмите «Проверить». Если они скрыты от ботов, напротив них в результатах будет написано «Запрещено правилом /*?*».

Только для Google

User-agent: Googlebot Disallow: /

Проверить, получилось ли сделать запрет, или нет, можно аналогичным способом, что и для Яндекса, только вам нужно будет посетить панель вебмастера Google Search Console. Если документ закрыт от поисковика, то напротив ссылки будет написано «Заблокировано по строке», и вы увидите ту самую строку, которая дала команду ботам не индексировать его.

Но с большой вероятностью вы можете увидеть «Разрешено». Здесь два варианта: либо вы что-то сделали неправильно, либо Google продолжает индексировать запрещенные в документе robots страницы. Я уже упоминал об этом выше, что для поисковых машин данный документ несет лишь рекомендационный характер, и окончательное решение по индексированию остается за ними.

Для других поисковиков

Все поисковики имеют собственных ботов с уникальными именами, чтобы вебмастера могли прописывать их в robots.txt и задавать для них команды. Представляем вашему вниманию самые распространенные (кроме Яндекса и Google):

- Поисковик Yahoo. Имя робота – Slurp.

- Спутник. Имя робота – SputnikBot.

- Bing. Имя робота – MSNBot.

Список имен всех ботов вы с легкостью найдете в интернете.

Скрыть изображения

Чтобы поисковики не могли индексировать картинки, пропишите такие команды (будут зависеть от формата изображения):

User-Agent: * Disallow: *.png Disallow: *.jpg Disallow: *.gif

Закрыть поддомен

Любой поддомен содержит собственный robots.txt. Как правило, он находится в корневой для поддомена папке. Откройте документ, и непосредственно там укажите:

User-agent: * Disallow: /

Если такого текстового документа в папке поддомена нет, создайте его самостоятельно.

3. С применением тега name=”robots”

Еще один способ, который поможет скрыть от роботов поисковых систем какой-либо документ или полностью весь сайт – использование мета-тега robots. Данный вариант является одним из самых приоритетных к исполнению для поисковиков. Для этого в любом месте, но обязательно внутри тегов <head> и </head>, нужно прописать код:

<meta name=”robots” content=”noindex, nofollow”/>

или

<meta name=”robots” content=”none”/>

4. В настройках сервера

И последний способ, о котором хочу вам рассказать – обращение к серверу. К этому варианту вебмастера прибегают в тому случае, когда роботы вообще никак не реагируют на действия, описанные выше. Такое иногда случается, и тогда приходится решать проблему в настройках сервера посредством файла .htaccess. Откройте его и пропишите в нем это:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot SetEnvIfNoCase User-Agent "^Yandex" search_bot SetEnvIfNoCase User-Agent "^Yahoo" search_bot SetEnvIfNoCase User-Agent "^Aport" search_bot SetEnvIfNoCase User-Agent "^msnbot" search_bot SetEnvIfNoCase User-Agent "^spider" search_bot SetEnvIfNoCase User-Agent "^Robot" search_bot SetEnvIfNoCase User-Agent "^php" search_bot SetEnvIfNoCase User-Agent "^Mail" search_bot SetEnvIfNoCase User-Agent "^bot" search_bot SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot SetEnvIfNoCase User-Agent "^Snapbot" search_bot SetEnvIfNoCase User-Agent "^WordPress" search_bot SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot SetEnvIfNoCase User-Agent "^Parser" search_bot

5. С помощью HTTP заголовка X-Robots-Tag

Это тоже своего рода настройка сервера с помощью файла .htaccess, но этот способ работает на уровне заголовков. Это один из самых авторитетных способов закрытия сайта от индексации, потому что он настраивается на уровне сервера.

Мы подробно расписали как этот способ настроить и использовать в нашей статье.

Как проверить индексацию сайта и страниц?

Если вы не знаете как это сделать, то мы расписали подробно, всевозможные способы в нашей статье — все способы проверки индексации сайта.

Заключение

Вне зависимости от того, по какой причине вы хотите закрыть сайт, отдельные его страницы или материалы от индексации, можете воспользоваться любым из перечисленных способов. Они простые в реализации, и на их настройку не потребуется много времени. Вы самостоятельно сможете скрыть нужную информацию от роботов, однако стоит учесть, что не все методы помогут на 100%.

как попросить поисковые системы не индексировать сайт

Индексация сайта — то, без чего невозможно SEO-продвижение. Если поисковые роботы не проиндексировали страницы вашего ресурса, то они не попали в индекс, и не отображаются пользователям в поисковой выдаче.

Почему не индексируется сайт?

Бывают ситуации, когда вебмастер ведет работу над SEO-оптимизацией сайта: активно наполняет его контентом, наращивает ссылки, а количество страниц в поисковой выдаче Google или «Яндекс» не увеличивается. Или что еще хуже — в поиске нет ни одного документа с сайта. С чем это связано? Самые распространенные причины:

«Яндекс» и Google не знает о вашем сайте

Если это новый ресурс, и вы только недавно открыли его для поисковых роботов, то, возможно, они просто его еще не нашли. Но эту проблему легко решить, выполнив несколько простых манипуляций:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters.

- Направить поисковых роботов на страницы сайта.

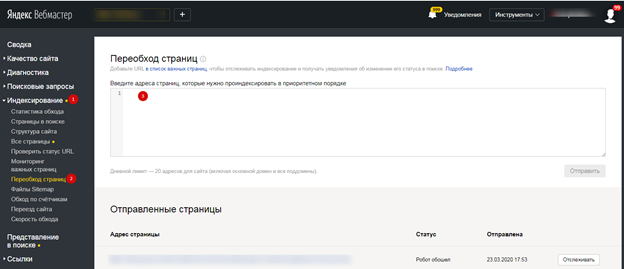

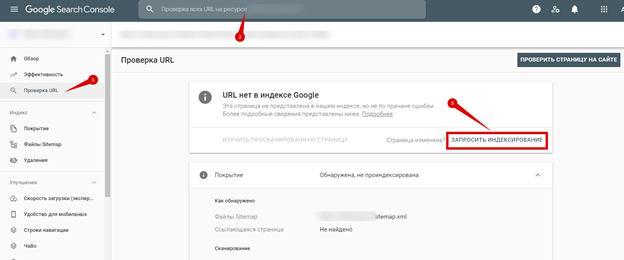

В «Яндекс.Вебмастер» («Индексирование» — «Переобход страниц»):

В Google Webmasters («Проверить URL» — Добавить адрес страницы — «Запросить Индексирование»):

Нужно будет немного подождать, пока робот обойдет страницы сайта. Как правило, на это уходит 1-2 часа (хотя может затянуться на несколько дней).

Сайт или страницы закрыты от индексации в файле robots.txt

Порой вебмастера, работая над сайтом, забывают открыть его для индексации. Но это легко исправить. Добавьте следующую команду в файл:

User-agent: * Disallow:

Это означает, что ресурс открыт для всех поисковых роботов. Но не забывайте, что нужно закрыть дубли на сайте, ведь не все содержимое должно принимать участие в поиске. Поэтому уделите заполнению файла robots.txt достаточно времени.

Настройки приватности

Если сайт управляется CMS WordPress, то по умолчанию в нем выставлены настройки приватности, которые запрещают индексацию поисковыми роботами. Авторизуйтесь в админке, перейдите в «Настройки — Чтение — Видимость для поисковых систем» и снимите галочку:

Сайт закрыт от поисковых роботов в мета-тегах

Запретить индексировать содержание страниц можно и с помощью мета-тега:

<meta name=«robots» content=«no index, nofollow»>

Как решить проблему:

- Посмотрите, нет ли такого тега на странице.

- Удалите код или добавьте другие мета-теги follow и index.

Ошибки сканирования

Проблемы с индексацией возникают и в том случае, если робот, обращаясь к ресурсу, не может просканировать его содержимое.

Проверьте все ли в порядке:

- Авторизуйтесь в Google Webmaster.

- Откройте «Сканирование» — «Ошибки сканирования»:

В идеале не должно быть никаких ошибок.

Сайт закрыт от роботов в .htaccess

В этом файле содержится правило 301 редиректа. Но помимо него, может быть прописана команда не индексировать сайт.

Чтобы проверить, выполните следующее:

- Найдите и откройте файл файл .htaccess на сервере.

- Проанализируйте содержимое кода.

Нестабильная работа сервера или хостинга

Выбирайте стабильный хостинг с хорошей репутацией. В противном случае, если роботы будут обращаться к сайту, он будет часто недоступен, а их попытки станут все реже. Через некоторое время они и вовсе откажутся заходить к вам на сайт.

Проблемы с индексацией AJAX/JavaScript

Поисковым роботам сложнее просканировать содержимое AJAX и JavaScript, чем HTML. Если вы допустите ошибки при оптимизации, то Google и «Яндекс» не проиндексируют определенные страницы или даже весь сайт.

Дубли контента внутри сайта

За дублирование контента поисковые системы наказывают санкциями, но это тоже одна из причин плохой индексации. К дублям может относиться одинаковый контент, открывающийся на разных страницах, мета-теги или даже страницы, если они доступны под двумя адресами (с www и без; http и https). Если не исправить проблему своевременно, то она негативно скажется на дальнейшем SEO-продвижении.

Плохая скорость загрузки

При плохой скорости загрузки ресурса, он может плохо индексироваться и потерять позиции, так как этот показатель относится к факторам ранжирования. Проверить насколько быстро загружается ваш сайт можно с помощью специального инструмента — Google Page Speed:

Поработайте над улучшением скорости загрузки сайта, учитывая рекомендации инструмента.

Домен с баном

Случается, что вебмастер выбирает и регистрирует созвучное имя для сайта, наполняет ресурс и ждет, когда он проиндексируется, но ничего не происходит. После анализа домена, выясняется, что домен ранее использовался и находится в бане поисковых систем.

Исправить такую ситуацию не просто. Придется написать в тех. поддержку «Яндекс», чтобы они пересмотрели ресурс или указали причину бана (если вы ее не знаете). Заниматься ли развитием сайта на этом домене — решать вам. Ориентируйтесь на то, что ответит вам техническая поддержка. Часто бывает проще начать все на новом домене.

Отсутствует sitemap

Не самая распространенная причина плохой индексации, но не стоит ее исключать. Создайте карту сайта и не забудьте добавить ее в сервисы для вебмастеров от Google и «Яндекс»:

В «Гугл вебмастер»:

Норма индексации в «Яндекс»

В среднем поисковая система «Яндекс» сканирует и добавляет в поисковую выдачу страницы несколько раз в месяц (2-4 раза). Однако авторитетные сайты с регулярным обновлением контента индексируются быстророботом и их материалы сразу попадают в поиск.

Нормы индексации в Google

Со скоростью индексации в Google ситуация обстоит несколько иначе. На нее может уйти от 1 дня до 2-х недель. Все зависит от показателей вашего ресурса. К примеру, сайты с постоянно обновляющимся контентом (новостники или форумы с высокой активностью) довольно часто посещают роботы. В результате попадание материалов в индекс — вопрос нескольких часов или дней.

Индексация среднестатистических сайтов с еженедельным обновлением контента осуществляется примерно за 2-4 дня. Новые сайты, которые только создали, могут в течение нескольких недель не попадать в индекс.

Если робот получает регулярные сигналы про обновление контента, он будет чаще заходить на такие сайты. Так, вы сможете увеличить скорость индексации новых материалов и получить дополнительный трафик.

Малополезные страницы для пользователей плохо индексируются и часто выпадают из индекса.

Как попросить поисковые системы временно не индексировать

Закрыть сайт от индексации можно несколькими способами:

- Специальные мета-теги robots noindex, nofollow. Используют, если нужно закрыть от индексации определенное содержимое на странице.

- Командой в файле robots.txt:

User-agent: * Disallow: /

Если ваш сайт построен на движке WordPress, то достаточно зайти в «Настройки — Чтение» и отключить галочку напротив «Видимость для поисковых систем»:

Выводы

Если сайт долго не индексируется Google или «Яндексом», значит, на это есть определенные причины. Ваша задача — обнаружить и исправить проблему. Через некоторое время после проделанных работ, проверьте «зашли» ли ваши страницы в индекс.

Если вы сделали все правильно, то результат не заставит себя долго ждать. В противном случае, можете написать в техподдержку поисковой системы, чтобы специалисты указали на причину плохой индексации.

А как вы работаете над улучшением скорости индексации сайта? Поделитесь опытом в комментариях.

советы сеошников — 5 советов

На чтение 6 мин. Опубликовано Обновлено

Если сайт не индексируется — то ни о каком продвижении сайта и речи быть не может. Гугл и Яндекс, это машины-роботы которые делают всё по своим определённым алгоритмам. И им важно чтобы сайт соответствовал тем требованиям — которые они выдвигают. На вопрос: «Почему не индексируется сайт?» — постараемся вам дать ответ в этой статье. И что нужно делать для того что бы сайт всё таки начали индексировать.

Блог INFOZET.RU готов вам предоставить советы «сеошников», и поделиться секретами… Присаживаемся поудобнее… И поехали!

Почему сайт не индексируется в Google

Для Google есть такой нюанс, чем старше сайт — тем лучше. И это касается всего остального. Чем больше того то…и того то…

Например Гугл любит ссылки на ваш сайт. Причём они должны быть у мощных и авторитетных сайтов. И чем больше соответственно, тем лучше. Для индексации гугла очень важна, так как это самая популярная поисковая система в мире, и в России в том числе. Тоже качается и про страны СНГ. Всегда Гугл был в первых рядах.

Для того чтобы разобраться почему именно эта поисковая система вас не любит, нужно понять и выявить причины.

Но мы с вами обойдёмся более быстрым и безболезненным методом. Вам нужно зарегистрироваться в Google Webmaster Tools. И после этого вообще сайт начнёт быстрее приниматься этой поисковой системой.

Яндекс пока не нашёл ваш сайт

На самом деле робот Яндекса это более современный робот, нежели Гугл-система. У Яндекса существует такое понятие как поведенческий фактор. Взято это было у своих соратников по социальным сетям, ведь именно там распространилось такое явление как — чем больше лайков, тем лучше.

Поведенческий фактор пользователя — это то, как реагируют интернет пользователи на ваш сайт или отдельную статью. Сколько ставят лайков, сколько проводят времени, переходят ли на следующую страницу, возвращаются ли на данный снова и снова. И таких факторов у Яндекса предостаточно. Чтобы выявить лучший сайт среди тысяч других ему приходится не мало попотеть над всеми трудами новоявленных авторов.

Ходит мнение что Яндекс куда более придирчив чем Гугл собрат. Однако для одних это размышление остаётся верным, а для других картина обстоит ровным счётом — да наоборот. Если бы вы когда нибудь пробовали уже продвигать сайт по Яндексу, то не могли не заметить как на одну статью он набрасывается и ставит в первую строчку Топа, а другую задвигает на крайний план. Это связано с очень тщательной но долгой индексацией. Робот долгий — но верный.

Советы SEO специалистов — 5 пунктов

Мы собрали лучшие советы от сео-специалистов в области продвижения и индексации сайтов. Стоит отметить, что данные пункты базовые, и подойдут для любых типов сайтов: будь то чисто информационный сайт или даже интернет-магазин.

1. Сайт закрыт в robots.txt

В robots.txt содержится не только общая информация — но и особо важная. И когда поисковой робот попадает на ваш сайт — первым делом он проверяет файл ROBOTS.TXT. Это нужно понимать, так как от этого может сильно затормозиться ваш сайт в поисковой выдаче, или же вы можете наоборот, помочь, сделать индексация с помощью него более быстрой и лёгкой.

Проверьте свой сайт на этом сервисе: https://webmaster.yandex.ru/tools/robotstxt

2. Приватные настройки из за которых не индексируется сайт

В каждой системе CSM которую вы используете, будь то WordPress или какая нибудь ещё — есть настройки приватности. И их нужно нам с вами правильно настроить.

Для того чтобы это сделать зайдите в сами настройки, и попробуйте разглядеть пункт чтение. Далее, если вы правильно всё нашли, то должны увидеть настройки поисковых систем или видимость поисковой выдачи. После этого нужно убрать соответствующие галочки — если таковые имеются. Если же их нет — значит со стороны приватности настроек по отношению к поисковым системам всё верно настроено.

3. Сайт закрыт в мета тегах

Там же, в настройках, можно будет посмотреть не закрыт ли ваш сайт ещё и в мета тегах.

Это тоже не маловажный фактор. Который кстати сказать очень даже скажется в дальнейшем, на общем продвижении сайта.

4. Хостинг работает не стабильно — сайт не индексируется никогда

Если ваш хостинг не эффективен, то можете забыть про нормально индексирование поисковиками.

К счастью или к сожалению — сайтов пруд пруди. Есть хорошие — есть плохие, но если вы когда то решив сэкономить, взяли дешёвый хостинг, это была ваша самая большая ошибка.

Что уж говорить — можно было сэкономить хоть на домене, но не на хостинге — это как никак ваша база данных. И если вы к ней отнеслись не подобающе когда то — то будьте любезны получить то же самое.

Поэтому — выбираем надёжный хостинг. Если вы ещё не на этом хостинге, то быстрее переносите свой сайт на него. По цене не кусается — а стабильность 100%.

5. Домен забанен — плохая история доменного имени

Перед тем как брать домен — его нужно проверит, так ли он хорош с виду. У него могла быть плохая история. И в своё время его могли просто забанить. Иначе, зачем он вообще освободился?

Подход к выбору домена должен быть не менее щепетилен.

Вывод

Итак, вот пять базовых нюансов которые вам нужно проверить и перепроверить.

Для успешной индексации сайта поисковиками не нужно лишних заморочек, однако именно эту, минимальную работу нужно разумеется провести. И желательно это сделать как можно раньше. Если сделать это через какое то время, то могут возникнуть сложности с индексацией и в целом отразится на здоровье сайта.

Вам будет интересна статья: Как писать SEO статьи для топ.

На этом пока всё. Определив, почему не индексируется сайт, вы уже сможете развивать своё детище дальше, и без лишней головной заморочки. Вы читали блог INFOZET.RU, удачи вам, и всего хорошего!

Мне нравится3Не нравится

Сканирование сайта — Инструменты Bing для веб-мастеров

Site Scan — это инструмент аудита сайта по запросу, который сканирует ваш сайт и проверяет общие технические проблемы SEO. Устранение этих проблем сделает вашу поисковую систему сайта более удобной для пользователей. С помощью этого инструмента вы можете улучшить производительность своего сайта не только в Bing, но и в других поисковых системах.

Настройка сканирования

Чтобы начать новое сканирование, перейдите к функции сканирования сайта в инструментах для веб-мастеров Bing и нажмите кнопку «Начать новое сканирование».Вам нужно будет ввести следующие данные:

Имя сканирования

Введите уникальное и логичное имя для вашего сканирования.

Область применения

Область видимости определяет границы сканирования. Вы можете использовать одну из следующих трех областей:

- Веб-сайт:

С этой областью мы будем сканировать ваш веб-сайт так же, как это делает Bingbot. Просто введите URL-адрес домашней страницы, поддомена или каталога, с которого вы хотите начать сканирование.Мы просканируем указанную страницу и перейдем по исходящим ссылкам, которые находятся в той же области.

Заметка - Субдомен — это расширение доменного имени, которое помогает организовывать и перемещаться по различным разделам веб-сайта. Пример поддомена: support.contoso.com или azure.microsoft.com

- Каталог — это дочерняя подпапка в вашем домене.Пример каталога: www.contoso.com/help/ или www.microsoft.com/windows

- Если вы хотите просканировать весь веб-сайт, вы должны ввести URL своей домашней страницы и выбрать «Сканировать все субдомены». Помните о своей ежемесячной квоте: если ваш сайт слишком велик, вы можете в конечном итоге использовать его полностью.

- Карта сайта:

Выберите этот вариант, если вы хотите сканировать определенную карту сайта.Просто введите URL-адрес карты сайта, которую вы хотите просканировать. Мы будем сканировать URL-адреса, найденные в карте сайта, но не будем сканировать исходящие ссылки на страницах.

- Список URL:

Выберите этот вариант, если вы хотите сканировать определенную карту сайта. Просто введите URL-адрес карты сайта, которую вы хотите просканировать. Мы будем сканировать URL-адреса, найденные в карте сайта, но не будем сканировать исходящие ссылки на страницах.

Ограничить сканирование до

Введите максимальное количество страниц для сканирования (сканирование прекратится при достижении этого лимита).Вы также можете просмотреть оставшуюся квоту на этот месяц ниже.

| Заметка |

|---|

Квота сканирования сайта, выделенная вашему сайту, рассчитывается автоматически на основе сигналов, доступных Bing. В настоящее время мы не поддерживаем запросы на увеличение этой квоты. |

Связь

Это позволяет получать обновления сканирования на зарегистрированный адрес электронной почты.

Расширенные настройки

- Максимальная глубина сканирования:

Этот параметр позволяет сканировать страницы только в пределах указанного количества кликов от начальной страницы. Сканирование остановится после достижения указанного предела глубины. Это может быть полезно для предотвращения непреднамеренного использования большого количества квоты URL.

- Скорость сканирования (URL-адресов в секунду):

Эта конфигурация определяет максимальное количество страниц, которые нужно сканировать в секунду.Будьте осторожны с этой настройкой. Более высокая скорость приведет к более быстрому сканированию, но может замедлить работу вашего веб-сайта, что повлияет на его пользователей.

- Параметры URL, которые следует игнорировать:

Параметры URL-адреса— это части адреса веб-страницы (URL-адреса), которые появляются после вопросительного знака (?). Раздел после вопросительного знака также называется «путем запроса» или «строкой запроса». Многие веб-сайты используют параметры строки запроса (также известные как динамические параметры) в качестве основной части архитектуры своего сайта для отслеживания идентификаторов сеансов, языков пользователя и т. Д.Однако использование параметров строки запроса может привести к тому, что несколько вариантов одного и того же URL-адреса будут указывать на одно и то же содержимое.

С этой конфигурацией вы можете информировать Bing о параметрах URL, которые можно безопасно игнорировать. Это поможет нам избежать многократного сканирования одной и той же страницы и тем самым сэкономит вашу квоту. Просто добавьте параметры URL, которые вы хотите, чтобы мы игнорировали при сканировании вашего сайта. Вы также можете найти некоторые рекомендуемые параметры, которые, по нашему мнению, можно игнорировать. Просто щелкните предложенный параметр, чтобы добавить его в список.

- Игнорировать Robots.txt:

Эту конфигурацию можно использовать для обхода директив Robot.txt и сканирования URL без каких-либо ограничений.

| Заметка |

|---|

Описание отчета о сканировании

После завершения сканирования вы можете получить доступ к деталям, нажав на сканирование.Вы попадете на страницу Scan Details , где вы можете увидеть такие детали, как:

- Состояние сканирования

- Количество отсканированных страниц

- Количество ошибок

- Количество предупреждений

- Список обнаруженных проблем, их серьезность и количество затронутых страниц

Мы разделили проблемы на три категории в зависимости от серьезности:

- Ошибок:

Это самые важные проблемы, которые мы обнаружили на вашем веб-сайте.Вы должны уделять первоочередное внимание решению этих проблем, поскольку они могут повлиять на индексируемость вашего сайта.

- Предупреждения:

Это проблемы средней степени серьезности, которые могут повлиять на состояние вашего SEO.

- Уведомления:

Это проблемы или рекомендации самой низкой степени серьезности, которые вы можете изучить после устранения всех ошибок и предупреждений.

В списке проблем вы можете увидеть серьезность проблемы и количество затронутых страниц.Нажав на проблему, вы перейдете на страницу сведений о проблеме. Здесь вы можете увидеть список страниц, затронутых этой проблемой, отсортированный по глубине страницы. Вы также можете загрузить этот список в формате .csv и поделиться им с соответствующей командой для решения проблемы.

Управление несколькими сканированиями

Вы можете увидеть список ваших прошлых сканирований и их сводку на домашней странице Site Scan. Для каждого сканирования сводка содержит такие сведения, как статус сканирования, возраст, отсканированные страницы, ошибки и предупреждения. Вы можете создать и сохранить до пяти сканов.

| Заметка |

|---|

Если вы сохранили сведения о пяти сканированиях, вам нужно будет удалить по крайней мере одно сканирование, прежде чем вы сможете начать новое сканирование. |

Чтобы удалить сканирование, щелкните меню сканирования справа и выберите «Удалить сканирование». Вы также можете просмотреть настройки сканирования, которые вы выбрали при настройке сканирования, или остановить текущее сканирование из этого меню.

причин, по которым ваш сайт индексируется, но не попадает в рейтинг, и как это исправить

- Отрасли промышленности

- КРОВЛЯ

- АДВОКАТЫ

- НЕКОММЕРЧЕСКАЯ

- ФРАНШИЗА

- ИЗДАТЕЛИ

- Новости Обучение

- Подрядчики

- МАЛЫЙ БИЗНЕС

- ДИЛЕРСТВО ПО АВТОМОБИЛЯМ

- Google Ads

- Расчет бюджета

- Google Ads

- Бюджетный калькулятор PPC для переездов

- Google Покупки

- Google Grant Management

- Services

- Локальное SEO

- Shopify SEO

- На странице SEO

- White label SEO

- White Label PPC

- WordPress SEO

- Электронная коммерция SEO

- SEO-аудит

- УДАЛЕНИЕ КОНТЕНТА

- БЛОГ

- О ДЖО

- Возьмите мою книгу

- Руководство по приостановке аккаунта Google Реклама

- Отзывы

- Примеры использования SEO

- Примеры использования PPC

- Ресурсы

- СВЯЗАТЬСЯ СО МНОЙ

- Возьмите мою книгу

- Подкаст

- ЗАПИСАТЬСЯ НА ЗВОНОК

ЗАПИСАТЬСЯ НА ЗВОНОК

- Отрасли промышленности

- КРОВЛЯ

- АДВОКАТЫ

- НЕКОММЕРЧЕСКАЯ

- ФРАНШИЗА

- ИЗДАТЕЛИ

- Новости Обучение

- Подрядчики

- МАЛЫЙ БИЗНЕС

- ДИЛЕРСТВО ПО АВТОМОБИЛЯМ

- Google Ads

- Расчет бюджета

- Google Ads

- Бюджетный калькулятор PPC для переездов

- Google Покупки

- Google Grant Management

- Services

- Локальное SEO

- Shopify SEO

- На странице SEO

- White label SEO

- White Label PPC

- WordPress SEO

- Электронная коммерция SEO

- SEO-аудит

- УДАЛЕНИЕ КОНТЕНТА

- БЛОГ

- О ДЖО

- Возьмите мою книгу

- Руководство по приостановке аккаунта Google Ads

- Отзывы

- Примеры использования SEO

- Примеры использования PPC

- Ресурсы

- СВЯЗАТЬСЯ СО МНОЙ

- Возьмите мою книгу

- Подкаст

- ЗАПИСАТЬСЯ НА ЗВОНОК

ЗАПИСАТЬСЯ НА ЗВОНОК

- Отрасли промышленности

- КРОВЛЯ

- АДВОКАТЫ

- НЕКОММЕРЧЕСКАЯ

- ФРАНШИЗА

- ИЗДАТЕЛИ

- Новости Обучение

- Подрядчики

- МАЛЫЙ БИЗНЕС

- АВТОМОБИЛЬНОЕ ПРЕДПРИЯТИЕ

- Google Ads

- Расчет бюджета

- Google Ads

- Калькулятор бюджета

- PPC для переездов

- Google Покупки

- Google Grant Management

- Services

- Локальное SEO

- Shopify SEO

- На странице SEO

- White label SEO

- White Label PPC

- WordPress SEO

- Электронная коммерция SEO

- SEO-аудит

- УДАЛЕНИЕ КОНТЕНТА

- БЛОГ

- О ДЖО

- Возьмите мою книгу

- Руководство по приостановке аккаунта Google Ads

- Отзывы

- Примеры использования SEO

- Примеры использования PPC

- Ресурсы

- СВЯЗАТЬСЯ СО МНОЙ

- Возьмите мою книгу

- Подкаст

- ЗАПИСАТЬСЯ НА ЗВОНОК

- Отрасли промышленности

- КРОВЛЯ

- АДВОКАТЫ

- НЕКОММЕРЧЕСКАЯ

- ФРАНШИЗА

- ИЗДАТЕЛИ

- Новости Обучение

- Подрядчики

- МАЛЫЙ БИЗНЕС

- АВТОМОБИЛЬНОЕ ПРЕДПРИЯТИЕ

- Google Ads

- Расчет бюджета

- Google Ads

- Калькулятор бюджета

- PPC для переездов

- Google Покупки

- Google Grant Management

- Services

- Локальное SEO

- Shopify SEO

- На странице SEO

- White label SEO

- White Label PPC

- WordPress SEO

- Электронная коммерция SEO

- SEO-аудит

- УДАЛЕНИЕ КОНТЕНТА

- БЛОГ

- О ДЖО

- Возьмите мою книгу

- Руководство по приостановке аккаунта Google Реклама

- Отзывы

- Примеры использования SEO

- Примеры использования PPC

- Ресурсы

- СВЯЗАТЬСЯ СО МНЕ

- Возьмите мою книгу

- Подкаст

- РАСПИСАНИЕ ЗВОНКА

Блог

Главная SEO Почему ваш сайт индексируется, но не ранжируется

Почему мой веб-сайт не отображается в поиске Google? • SEO-механик

Почему ваш сайт не отображается в поиске Google

Ваш сайт не отображается в результатах поиска Google?

Проверьте, проиндексирован ли ваш сайт, выполнив поиск по его точному URL-адресу или имени домена без каких-либо других слов (например, http: // www.yourdomain.com).

Если ваш сайт не отображается в результатах поиска Google или его эффективность ниже, чем когда-либо, проверьте эффективность поиска по вашим сайтам. в Google.

Как проверить поисковый индекс в Google

Почему важен поисковый рейтинг

Подавляющее большинство людей не переходят на первую страницу результатов поиска. Согласно этому исследованию, верхние позиции в органических результатах поиска Google получают 33 процента трафика по сравнению с 18 процентами для второй позиции, и оттуда трафик только ухудшается.

Таким образом, недостаточно, чтобы ваш сайт был проиндексирован Google, Bing и Yahoo.

Почему сайты не занимают места в результатах поиска

Гугл хитрый. Вот что может мешать вашему сайту появляться в результатах поиска:

- Google еще не проиндексировал ваш сайт (слишком новый)

- Ваш веб-сайт не оптимизирован для сканирования поисковыми системами

- Ваш рынок ключевых слов очень конкурентный

- На вашем веб-сайте нет тегов «без индекса»

- Ваш сайт был оштрафован и удален из Google

Ниже приведены общие причины (подробно), по которым ваш сайт (WordPress, Wix и Squarespace) не ранжируется, а — как появляется в поиске Google:

1.Google еще не проиндексировал ваш сайт

Иногда поисковой системе может потребоваться неделя или больше, чтобы обновить результаты поиска. Это потому, что ваш веб-сайт новый и на нем нет входящих ссылок.

Сначала создайте учетную запись в инструментах Google для веб-мастеров. Когда вы регистрируетесь и указываете Google на свой sitemap.xml URL, вы можете запросить у них повторное сканирование ваших URL. Однако запросов так много, что функция не всегда работает сразу (особенно если у вас новый или большой сайт).

Если вы не хотите создавать учетную запись в Инструментах Google для веб-мастеров, попробуйте эту ссылку, чтобы добавить свой URL в Google: http://www.google.com/addurl/

Google не добавляет все отправленные URL-адреса в свой индекс и не может делать прогнозов или гарантировать, когда или будут ли отправленные URL-адреса появиться в их индексе. Но если ваш новый веб-сайт просканируется, обычно требуется еще одна или две недели, чтобы он был помещен в индекс.

2. Ваш сайт слишком новый

Вы только что создали и запустили свой новый веб-сайт? Обычно это может занять до четырех недель, прежде чем он начнет отображаться в результатах поиска.Хотя мы, возможно, привыкли быстро выводить информацию в Интернет, индексы поисковых систем могут быть довольно медленными. Так что сидите спокойно, подождите и узнайте больше об алгоритмах поисковых систем, прежде чем слишком нервничать.

3. На вашем веб-сайте нет тегов «без индекса»

Вы можете использовать собственный код, чтобы указать поисковым системам не индексировать ваш сайт или определенные страницы. Если вы или кто-то из разработчиков вашего сайта добавили этот код, это объяснило бы, почему он не отображается в результатах поиска.

4. Ваш веб-сайт не оптимизирован для сканирования поисковыми системами

После того, как вы отправите свой веб-сайт в поисковую систему, на ваш сайт отправляется паук, чтобы сканировать его на предмет содержания.Эти пауки не просматривают ваш сайт, как посетитель.

Они сканируют ваш сайт на наличие метаконтента, насыщенности ключевыми словами, релевантного контента и многих других факторов.

Следовательно, вам необходимо учитывать, какой контент поисковые системы действительно видят на ваших веб-страницах.

5. Ваш рынок ключевых слов очень конкурентный

Поисковые системы помогают миллионам пользователей во всем мире перемещаться по Интернету и находить конкретный контент на миллиардах веб-сайтов.

Убедитесь, что вы ориентируетесь на менее конкурентный рынок ключевых слов, чтобы привлечь внимание вашего потребителя.

6. Не все ключевые слова равны

Легко ранжироваться по нерелевантным ключевым словам в поисковых системах. Трудно ранжироваться по ключевым словам, которые приносят прибыль вашему бизнесу.

Сложность двоякая: одна — определение наиболее прибыльного ключевого слова для вашего бизнеса, а вторая — знание того, как вывести вас на страницу 1.

7. Ваш веб-сайт удален из Google

Google может временно или навсегда удалить сайты из своего индекса и результатов поиска, если считает, что обязан сделать это по закону, если сайты не соответствуют рекомендациям Google по качеству, или по другим причинам, например, если сайты отвлекают внимание пользователей способность находить нужную информацию.

Вот различные способы, которыми Google может удалить ваш сайт из результатов поиска:

- Деиндексировано — Когда ваш домен полностью удален из Google. Также известен как Banned.

- Penalized — Когда ваш домен или страница все еще существует, но ни одна из ваших страниц не может быть найдена с помощью очень прямых поисковых запросов. Это наказание может быть автоматически применено алгоритмом Google или вручную инженером по качеству Google.

- Песочница — Ваш домен или страница не были деиндексированы или наложены штрафы, но трафик, который вы получали от Google, внезапно резко падает.

Если ваш сайт заблокирован в нашем индексе из-за нарушения наших рекомендаций по обеспечению качества, Google может предупредить вас об этом с помощью Search Console.

Если вы получили уведомление о том, что ваш сайт нарушает наши рекомендации по обеспечению качества, вы можете изменить свой сайт так, чтобы он соответствовал этим правилам, а затем отправить свой сайт на повторную проверку.

Вы блокируете сканирование вашего сайта поисковыми системами

WordPress имеет встроенную функцию, которая позволяет указать поисковым системам не индексировать ваш сайт.Эта функция автоматически включается при запуске нового веб-сайта WordPress. Поэтому вы должны вручную отключить его. Все, что вам нужно сделать, это зайти в «Настройки » »Читать и установить флажок рядом с опцией« Видимость в поисковых системах ».

Как сделать так, чтобы ваш сайт появился в Google

Вы хотите, чтобы ваш веб-сайт занимал первое место на первой странице (на которой обычно имеется 10 списков веб-сайтов). В зависимости от вашего бизнеса вам нужно будет использовать стратегии поисковой оптимизации и SEO, чтобы улучшить свой рейтинг.

1. Проведите тщательный SEO-аудит

Чтобы обеспечить больший успех в будущем, сейчас самое время провести SEO-аудит вашего сайта. Это даст вам четкое представление о том, где вы находитесь в отношении:

- Оптимизация на месте

- Оптимизация вне сайта

- Выбор ключевого слова

И это только начало. Узнайте, как провести аудит вручную здесь: https://www.seomechanic.com/how-to-perform-seo-audit/

2. Добавьте ключевые слова в контент своего сайта

Ключевые слова могут состоять из одного слова или короткой фразы из четырех или пяти слов.Это должны быть термины, которые имеют отношение к вашему сайту и которые люди могут использовать при поиске в Google.

Очевидно, они должны иметь отношение к тому, чему посвящен ваш сайт.

3. Используйте метатеги, чтобы добавить ключевое слово

Мета-теги — это скрытый код — посетители вашего веб-сайта их не видят, но «боты» поисковой системы Google, сканирующие ваш сайт, их обнаружат.

Вы можете добавить эти метатеги на свой сайт самостоятельно, если у вас есть программа для веб-дизайна или если вы знаете, как кодировать HTML.

4. Найдите ключевые слова, которые не являются слишком конкурентоспособными

Мы предлагаем вам использовать бесплатный Планировщик ключевых слов Google, чтобы выяснить это.

Этот инструмент исследования ключевых слов позволяет вам оценивать популярность определенных поисковых запросов, а также уровень конкуренции, с которым вы сталкиваетесь, используя их.

Высококонкурентные ключевые слова могут вызвать борьбу десятков тысяч веб-сайтов за них, поэтому вы с меньшей вероятностью попадете на первую страницу Google, если выберете их.

5. Ищите обратные ссылки

веб-страниц, содержащих обратные ссылки на ваш сайт. Важным фактором для поисковых систем являются качественные органические обратные ссылки.Это то, что ищут поисковые системы.

Если у вас есть несколько веб-сайтов, которые ссылаются на ваш веб-сайт, Google повысит доверие к вашей странице и повысит рейтинг в поиске.

6. Создайте объявление для своего сайта в Google Мой бизнес

Этот совет предназначен для обычных предприятий с физическим местонахождением.

Google Мой бизнес связывает ваш сайт со списком на карте, поэтому, когда люди будут искать вашу компанию или искать по ключевым словам, связанным с вашей компанией, они найдут список на карте Google и смогут перейти на ваш сайт для получения дополнительной информации.

7. Размещайте контент, имеющий отношение к вашему бизнесу

Используйте статьи или другие материалы, относящиеся к предоставляемым вами продуктам и услугам. Не используйте наполнитель, который имеет лишь слабое родство.

Алгоритм Google ранжирует сайты с оригинальным релевантным содержанием выше, чем сайты с содержанием, повторяющимся в других местах.

8. Проанализируйте свое техническое SEO

Мой бесплатный отчет по поисковой оптимизации — отличный ресурс для определения производительности конкретной поисковой системы URL.Мы также даем вам длинный контрольный список способов, которыми вы можете улучшить SEO своих сайтов самостоятельно.

Бонусный совет: SEO обслуживание

После того, как вы оптимизировали свой веб-сайт, чтобы попасть на эту важную первую страницу Google, вы не можете останавливаться, всегда нужно управлять SEO.

Как только вы подниметесь на первую страницу рейтинга, ваши конкуренты будут преследовать вас со своими собственными стратегиями SEO, стремясь сбить вас с вершины.

Или клиенты могут начать поиск по другим ключевым словам.

Итог: Ваш сайт будет нуждаться в постоянном SEO-обзоре, чтобы поддерживать рейтинг в поисковых системах.

Заключение

Для владельцев бизнеса с сайтами WordPress, Squarespace и Wix очень важно узнать о SEO и улучшить свое присутствие в Интернете. Фактически, 63% американцев получают доступ к мобильной сети каждый день , и это число постоянно растет.

О Чарли Роуз

Для меня нет ничего важнее, чем работоспособность и эффективность поиска вашего веб-сайта.Хотите узнать больше? Давай общаться.

Просмотреть все сообщения Чарли Роуза

Поисковая индексация в Windows 10: FAQ

Индексирование содержимого вашего ПК помогает вам быстрее получать результаты при поиске файлов и других вещей. Узнай, как это работает.

Что такое индексация?

Индексирование — это процесс просмотра файлов, сообщений электронной почты и другого содержимого на вашем компьютере и каталогизация их информации, такой как слова и метаданные в них.Когда вы выполняете поиск на своем компьютере после индексации, он просматривает список терминов, чтобы быстрее находить результаты.

Когда вы впервые запускаете индексацию, это может занять до пары часов. После этого индексация будет выполняться на вашем компьютере в фоновом режиме по мере того, как вы его используете, только повторно индексируя обновленные данные.

Как индексирование ускоряет поиск?

Во многом аналогично указателю в книге, наличие цифрового указателя позволяет вашему компьютеру и приложениям быстрее находить контент, ища термины или общие свойства, такие как дата создания файла.Полностью построенный индекс может возвращать ответы на такие поисковые запросы, как «Показать все песни Coldplay» за доли секунды, по сравнению с минутами, которые могли бы занять без индекса.

Какая информация индексируется?

По умолчанию, все свойства ваших файлов индексируются, включая имена файлов и полные пути к файлам. Для файлов с текстом их содержимое индексируется, чтобы вы могли искать слова в файлах.

Установленные вами приложения также могут добавлять свою информацию в индекс для ускорения поиска.Например, Outlook 2016 по умолчанию добавляет все электронные письма, синхронизированные с вашим компьютером, в индекс и использует индекс для поиска в приложении.

Какие приложения используют индекс?

Многие встроенные приложения на вашем ПК так или иначе используют индекс. File Explorer, Photos и Groove используют его для доступа и отслеживания изменений в ваших файлах. Microsoft Edge использует его для отображения результатов истории браузера в адресной строке. Outlook использует его для поиска в вашей электронной почте.Кортана использует его для ускорения результатов поиска на вашем компьютере.

Многие приложения в Microsoft Store также зависят от индекса для предоставления актуальных результатов поиска для ваших файлов и другого контента. Отключение индексации приведет к тому, что эти приложения будут либо работать медленнее, либо вообще не работать, в зависимости от того, насколько сильно они на это полагаются.

Почему индексация на моем компьютере всегда выполняется автоматически?

Ваш компьютер с Windows 10 постоянно отслеживает изменения в файлах и обновляет индекс с учетом последней информации.Для этого он открывает недавно измененные файлы, просматривает изменения и сохраняет новую информацию в индексе.

Где хранится индексная информация?

Все данные, собранные в результате индексирования, хранятся локально на вашем ПК. Ничего из этого не отправляется ни на какой другой компьютер или в Microsoft. Однако приложения, которые вы устанавливаете на свой компьютер, могут читать данные в индексе, поэтому будьте осторожны с тем, что вы устанавливаете, и убедитесь, что вы доверяете источнику.

Сколько места занимает индекс?

Эмпирическое правило состоит в том, что индекс должен быть меньше 10 процентов от размера проиндексированных файлов. Например, если у вас 100 МБ текстовых файлов, индекс для этих файлов будет меньше 10 МБ.

Индекс может занимать больший процент, если у вас много очень маленьких файлов (<4 КБ) или если вы индексируете компьютерный код. В обоих случаях размер индекса резко увеличится пропорционально размеру файлов.Если у вас много маленьких файлов и вам нужно сэкономить место на вашем компьютере, рассмотрите возможность удаления местоположения этих файлов из индексации, перейдя на страницу панели управления «Параметры индексирования» и выбрав Изменить .

Какие языки можно индексировать?

Все языковые пакеты, установленные с Windows, включают информацию для индексирования содержимого на этом языке. Если у вас есть файлы или другой контент на языке, который не установлен на вашем компьютере, индекс будет пытаться сделать его доступным для поиска, но это не всегда возможно.

Чтобы установить дополнительные языковые пакеты и убедиться, что язык доступен для поиска на вашем ПК, перейдите в раздел Настройки > Время и язык > Регион и язык , а затем выберите Добавить язык .

Какие типы файлов можно индексировать?

Чтобы просмотреть список типов файлов, которые можно проиндексировать, перейдите на страницу панели управления «Параметры индексирования» и выберите Дополнительно > Типы файлов .

Могу ли я изменить, какая часть информации файла индексируется?

Да. Есть два варианта того, какую часть файла индексировать: либо только свойства, либо свойства и содержимое. Только для свойств индексирование не будет смотреть на содержимое файла или делать его доступным для поиска. Вы по-прежнему сможете выполнять поиск по имени файла, но не по содержимому.

Отказ от индексации содержимого файлов может уменьшить размер индекса, но в некоторых случаях это затрудняет поиск файлов.

Чтобы выбрать параметр для каждого типа файла, перейдите на страницу панели управления «Параметры индексирования» и выберите Дополнительно > Типы файлов .

Важность индексации вашей веб-страницы в Google

Фактически, большая часть трафика, генерируемого веб-сайтом, поступает из результатов поисковых систем, особенно Google, через который проходит более 90% интернет-трафика.

Вот почему так важно, чтобы ваша страница отображалась в результатах Google.Отображение вашей страницы в результатах поиска поисковой системы называется индексированием. Когда вы успешно индексируете, результатом будет больше трафика, и всякий раз, когда вы публикуете новый контент, он будет обнаруживаться быстрее. Иногда эта работа настолько сложна, что вам нужны хорошие службы индексации ссылок .

Как быть, если вы не управляли процессом индексации?

Если вам не удалось проиндексировать свою веб-страницу в Google, она не будет отображаться в результатах поиска.Иногда возможно, что ваш сайт плохо проиндексирован в Google. Это означает, что, например, поисковая система предлагает результаты на главной странице вашего сайта, но не показывает результаты, относящиеся к другим страницам.

Как решить проблемы

Для их решения необходимо убедиться, что ваш робот Googlebot всегда будет посещать и индексировать ваш сайт. «Человек», отвечающий за отслеживание и индексацию новых сайтов, — это робот Googlebot, это робот для отслеживания, созданный компанией.

Как Google индексирует мою веб-страницу

Как работает Googlebot? Это выполняет алгоритмическое отслеживание с определенной частотой, начиная с сайтов, которые были созданы в прошлых процессах отслеживания, и с учетом карт сайта (или карт сайтов), созданных веб-мастерами.Когда вы посещаете эти страницы, вы сможете обнаружить ссылки SRC и HREF, добавив их в список страниц, которые вы должны посетить.

В результате этого процесса обнаруживаются новые интернет-страницы, а также обновления, в которых они существовали раньше, и проблемы с устаревшими ссылками. Он также анализирует качество контента, количество слов, содержащихся на странице, расположение этих слов и метки заголовков, среди прочего.

Можете ли вы ускорить процесс индексации вашей веб-страницы в Google?

Затем, чтобы иметь возможность проиндексировать свой веб-сайт в Google, вам придется подождать, пока робот Googlebot обнаружит его и включит.Это процесс, который может занять от 2 до 4 недель.

Можно ли что-нибудь сделать, чтобы это произошло как можно быстрее? Ответ положительный. Расскажу, как это сделать:

Отправить карту сайта в Google

Как я упоминал ранее, карта сайта важна в процессе отслеживания роботом Google; и в основном это XML-документ, который включен на сервер веб-страницы и содержит список каждой из страниц, составляющих ваш сайт. Через карту сайта Google вы можете узнать, когда вы добавляете новые страницы.Чем больше вы обновляете свой сайт, тем чаще робот Googlebot будет посещать ваш сайт, чтобы проверить наличие обновлений. Тогда важно не только иметь карту сайта, но и постоянно обновлять ее.

Когда на вашей странице будет карта сайта, вы можете добавить ее в Инструменты Google для веб-мастеров. Для этого вам потребуется учетная запись Google. Процесс прост: сначала вы должны добавить новый сайт в Инструменты для веб-мастеров, а затем перейти в Trace и выбрать вариант карты сайта (или карты сайта). Там вам просто нужно добавить ссылку и все.

Добавить URL в поисковые системы

При регистрации сайта в Google Webmaster Tools вы должны проделать то же самое с инструментами для веб-мастеров других поисковых систем, таких как: Bing, Yahoo и Yandex.

Социальные сети

Помимо карт сайта, ссылки — это второе, что анализирует робот Googlebot, и способ быстро получить их — через профили в социальных сетях (Facebook, Twitter, Google +, LinkedIn, Pinterest, YouTube). Также может быть полезно добавить ссылку на новый сайт в существующие профили.

Почему мой рейтинг упал? Руководство по поиску и устранению неисправностей SEO

Хотя повышение рейтинга поисковых систем по поисковым запросам, относящимся к вашей отрасли, больше не является единственным показателем для измерения успеха SEO, значимость сильных позиций в этих поисковых запросах нельзя игнорировать для подавляющего большинства веб-сайтов. Что еще более важно, внезапные падения этих позиций, которые приводят к отражающему снижению трафика на ваш сайт, могут иметь серьезные негативные последствия для чистой прибыли.

Хотя повышение рейтинга поисковых систем по поисковым запросам, относящимся к вашей отрасли, больше не является единственным показателем для измерения успеха SEO, значимость сильных позиций в этих поисковых запросах нельзя игнорировать для подавляющего большинства веб-сайтов. Что еще более важно, внезапные падения этих позиций, которые приводят к отражающему снижению трафика на ваш сайт, могут иметь серьезные негативные последствия для чистой прибыли.

В этом руководстве я исследовал некоторые из наиболее распространенных причин внезапной и резкой потери рейтинга и падения органического трафика. Хотя этот список далеко не исчерпывающий, он должен служить хорошей отправной точкой для процесса диагностики причины потери рейтинга и дать представление о способах изменить ситуацию.

Предисловие: хотя проблемы с рейтингом могут возникать с любым количеством поисковых систем, для целей этого руководства я использовал Google в качестве примера.Это потому, что это, безусловно, самая популярная поисковая система в Великобритании и, вероятно, будет основной поисковой системой, направляющей трафик на любой британский веб-сайт. Тем не менее, проблемы и процесс диагностики будут во многом одинаковыми, независимо от того, в каких поисковых системах вы испытываете колебания в рейтинге, поэтому это руководство должно быть полезным для всех.

Потеряли ранжирование или деиндексированные страницы? Знайте, что до того, почему