Robots.txt для WordPress — как настроить правильно в 2021 году?

В интернете можно найти много публикаций на тему, как составить лучший (или даже самый лучший) файл robots.txt для WordPress. При этом в ряде таких популярных статей многие правила не объясняются и, как мне кажется, вряд ли понимаются самими авторами. Единственный обзор, который я нашел и который действительно заслуживает внимания, — это статья в блоге wp-kama. Однако и там я нашел не совсем корректные рекомендации. Понятно, что на каждом сайте будут свои нюансы при составлении файла robots.txt. Но существует ряд общих моментов для совершенно разных сайтов, которые можно взять за основу. Robots.txt, опубликованный в этой статье, можно будет просто копировать и вставлять на новый сайт и далее дорабатывать в соответствии со своими нюансами.

Более подробно о составлении robots.txt и значении всех его директив я писал здесь. Ниже я не буду подробно останавливаться на значении каждого правила. Ограничусь тем, что кратко прокомментирую что для чего необходимо.

Ограничусь тем, что кратко прокомментирую что для чего необходимо.

Правильный Robots.txt для WordPress

Действительно самый лучший robots.txt, который я видел на данный момент, это роботс, предложенный в блоге wp-kama. Ряд директив и комментариев я возьму из его образца + внесу свои корректировки. Корректировки коснутся нескольких правил, почему так напишу ниже. Кроме того, напишем индивидуальные правила для всех роботов, для Яндекса и для Google.

Ниже привожу короткий и расширенный вариант. Короткий не включает отдельные блоки для Google и Яндекса. Расширенный уже менее актуален, т.к. теперь нет принципиальных особенностей между двумя крупными поисковиками: обеим системам нужно индексировать файлы скриптов и изображений, обе не поддерживают директиву Host. Тем не менее, если в этом мире снова что-то изменится, либо вам потребуется все-таки как-то по-отдельному управлять индексацией файлов на сайте Яндексом и Гугл, сохраню в этой статье и второй вариант.

Еще раз обращаю внимание, что это базовый файл robots. txt. В каждом конкретном случае нужно смотреть реальный сайт и по-необходимости вносить корректировки. Поручайте это дело опытным специалистам!

txt. В каждом конкретном случае нужно смотреть реальный сайт и по-необходимости вносить корректировки. Поручайте это дело опытным специалистам!

Короткий вариант (оптимальный)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest. xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ruРасширенный вариант (отдельные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т. к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.

к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc. php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.

php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т. д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно).

д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ru

Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ruВ примере я не добавляю правило Crawl-Delay, т.к. в большинстве случаев эта директива не нужна. Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает). Подробнее про это читайте в статье Robots.txt.

Ошибочные рекомендации других блогеров для Robots.txt на WordPress

- Использовать правила только для User-agent: *

Для многих поисковых систем не требуется индексация JS и CSS для улучшения ранжирования, кроме того, для менее значимых роботов вы можете настроить большее значение Crawl-Delay и снизить за их счет нагрузку на ваш сайт.

- Прописывание Sitemap после каждого User-agent

Это делать не нужно. Один sitemap должен быть указан один раз в любом месте файла robots.txt - Закрыть папки wp-content, wp-includes, cache, plugins, themes

Это устаревшие требования. Однако подобные советы я находил даже в статье с пафосным названием «Самые правильный robots для WordPress 2018»! Для Яндекса и Google лучше будет их вообще не закрывать. Или закрывать «по умному», как это описано выше. - Закрывать страницы тегов и категорий

Если ваш сайт действительно имеет такую структуру, что на этих страницах контент дублируется и в них нет особой ценности, то лучше закрыть. Однако нередко продвижение ресурса осуществляется в том числе за счет страниц категорий и тегирования. В этом случае можно потерять часть трафика - Закрывать от индексации страницы пагинации /page/

Это делать не нужно. Для таких страниц настраивается тег rel=»canonical», таким образом, такие страницы тоже посещаются роботом и на них учитываются расположенные товары/статьи, а также учитывается внутренняя ссылочная масса.

- Прописать Crawl-Delay

Модное правило. Однако его нужно указывать только тогда, когда действительно есть необходимость ограничить посещение роботами вашего сайта. Если сайт небольшой и посещения не создают значительной нагрузки на сервер, то ограничивать время «чтобы было» будет не самой разумной затеей. - Ляпы

Некоторые правила я могу отнести только к категории «блогер не подумал». Например:Disallow: /20— по такому правилу не только закроете все архивы, но и заодно все статьи о 20 способах или 200 советах, как сделать мир лучше 🙂

Спорные рекомендации других блогеров для Robots.txt на WordPress

- Комментарии

Некоторые ребята советуют закрывать от индексирования комментарииDisallow: /commentsиDisallow: */comment-*. - Открыть папку uploads только для Googlebot-Image и YandexImages

User-agent: Googlebot-ImageСовет достаточно сомнительный, т.

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/ к. для ранжирования страницы необходима информация о том, какие изображения и файлы размещены на ней.

к. для ранжирования страницы необходима информация о том, какие изображения и файлы размещены на ней.

Спасибо за ваше внимание! Если у вас возникнут вопросы или предложения, пишите в комментариях!

Оцените статью

Загрузка…

Друзья, буду благодарен за ваши вопросы, дополнения и рекомендации по теме статьи. Пишите ниже в комментариях.

Буду благодарен, если поставите оценку статье.

Полное руководство по файлу robots.txt для WordPress

Чтобы быть уверенным, что ваш сайт хорошо ранжируется в результатах поисковых систем (Search Engine Result Pages – SERPs), вам нужно сделать его наиболее важные страницы удобным для поиска и индексирования «роботоми» («ботами») поисковых движков. Хорошо структурированный файл robots.txt поможет направить этих ботов на страницы, которые вы хотите проиндексировать (и пропустить другие).

В этой статье мы собираемся раскрыть такие вопросы:

- Что такое файл robots.

txt и почему он важен

txt и почему он важен - Где находится robots.txt для WordPress

- Как создать файл robots.txt

- Какие правила должны быть в файле robots.txt для WordPress

- Как проверить файл robots.txt и отправить его в консоль Google Search.

К концу нашего обсуждения у вас будет всё необходимое для настройки отличного файла robots.txt для вашего сайт на WordPress. Начнём!

Что такое файл

robots.txt для WordPress и зачем он нужен

Когда вы создаёте новый сайт, поисковые движки будут отправлять своих миньонов (или роботов) для сканирования и создания карты всех его страниц. Таким образом, они будут знать, какие страницы показывать как результат, когда кто-либо ищет по относящимся ключевым словам. На базовом уровне это достаточно просто.

Проблема состоит в том, что современные сайты содержат множество других элементом, кроме страниц. WordPress позволяет вам устанавливать, например, плагины, которые часто имеют свои каталоги. Вы не хотите показывать это в результатах поисковой выдачи, поскольку они не соответствуют содержимому.

Вы не хотите показывать это в результатах поисковой выдачи, поскольку они не соответствуют содержимому.

Что делает файл robots.txt, так это обеспечивает ряд указаний для поисковых роботов. Он говорит им: «Посмотрите здесь, но не заходите в эти области!». Этот файл может настолько подробным, на сколько вы захотите и его очень просто создавать, даже если вы не технический волшебник.

На практике, поисковые движки всё равно будут сканировать ваш сайт, даже если вы не создадите файл robots.txt. Однако, не создавать его является весьма нерациональным шагом. Без этого файла вы оставите роботам для индексации весь контент вашего сайта и они решать, что можно показывать все части вашего сайта, даже те, которые бы вы хотели скрыть от общего доступа.

Более важный момент, без файла robots.txt, у вас будет очень много обращений для сканирования ботами вашего сайта. Это негативно скажется на его производительности. Даже если посещаемость вашего сайта ещё невелика, скорость загрузки страницы – это то, что всегда должно быть в приоритете и на высшем уровне. В конце концов, есть всего несколько моментов, которые люди не любят больше, чем медленная загрузка сайтов.

В конце концов, есть всего несколько моментов, которые люди не любят больше, чем медленная загрузка сайтов.

Где находится файл robots.txt для WordPress

Когда вы создаёте сайт на WordPress, файл robots.txt создаётся автоматически и располагается в вашем главном каталоге на сервере. Например, если ваш сайт расположен здесь: yourfakewebsite.com, вы сможете найти его по адресу yourfakewebsite.com/robots.txt и увидеть примерно такой файл:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Это пример самого простого базового файла robots.txt. Переводя на понятный человеку язык, правая часть после User-agent: объявляет, для каких роботов предназначены правила ниже. Звёздочка означает, что правило универсальное и применяется для всех ботов. В данном случае файл говорит ботам, что им нельзя сканировать каталоги wp-admin и wp-includes. Смыл этих правил заключается в том, что данные каталоги содержат очень много файлов, требующих защиты от общего доступа.

Смыл этих правил заключается в том, что данные каталоги содержат очень много файлов, требующих защиты от общего доступа.

Конечно же, вы можете добавить больше правил в свой файл. Прежде чем вы это сделаете, вам нужно понять, что это виртуальный файл. Обычно, WordPress robots.txt находится в корневом(root) каталоге, который часто называется public_html или www (или по названию имени вашего сайта):

Надо отметить, что файл robots.txt для WordPress, устанавливаемый по умолчанию, не доступен для вас ни из какого каталога. Он работает, но если вы захотите внести изменения, вам нужно создать ваш собственный файл и загрузить его в корневой каталог в качестве замены.

Мы рассмотрим несколько способов создания файла robots.txt для WordPress за минуту. А сейчас давайте обсудим, как определить, какие правила нужно включить в файл.

Какие правила нужно включить в файл robots.

txt для WordPress

txt для WordPress

В предыдущем разделе мы видели пример генерируемого WordPress файла robots.txt. Он включает в себя только два коротких правила, но для большинства сайтов их достаточно. Давайте взглянем на два разных файла robots.txt и рассмотрим, что каждый из них делает.

Вот наш первый пример файла robots.txt WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: /checkout/ Disallow: /images/ Disallow: /forum/

Этот файл robots.txt создан для форума. Поисковые системы обычно индексируют каждое обсуждение на форуме. В зависимости от того, какая тематика вашего форума, вы можете захотеть запретить индексацию. Так, например, Google не будет индексировать сотни коротких обсуждения пользователей. Вы также можете установить правила, указывающие на конкретную ветвь форума, чтобы исключить её, и позволить поисковым системам обходить остальные.

Вы также заметили строку, которая начинается с Allow: / вверху файла. Эта строка говорит ботам, что они могут сканировать все страницы вашего сайта, кроме установленных ниже ограничений. Также вы заметили, что мы установили эти правила как универсальные (со звёздочкой), как было в виртуальном файле WordPress robots.txt.

Эта строка говорит ботам, что они могут сканировать все страницы вашего сайта, кроме установленных ниже ограничений. Также вы заметили, что мы установили эти правила как универсальные (со звёздочкой), как было в виртуальном файле WordPress robots.txt.

Давайте проверим другой пример файла WordPress robots.txt:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ User-agent: Bingbot Disallow: /

В этом файле мы устанавливаем те же правила, что идут в WordPress по умолчанию. Хотя мы также добавляем новый набор правил, которые блокируют поисковых роботов Bing от сканирования нашего сайта. Bingbot, как можно понять, это имя робота.

Вы можете совершенно конкретно задавать поисковых роботов отдельного движка для ограничения/разрешения их доступа. На практике, конечно, Bingbot очень хороший (даже если не такой хороший, как Googlebot). Однако, есть и много вредоносных роботов.

Плохой новостью является то, что они далеко не всегда следуют инструкциям из файла robots. txt (они же всё же работают как террористы). Следует иметь в виду, что, хотя большинство роботов будут использовать указания, представленные в этом файле, но вы не можете принудить их это делать. Мы просто хорошо просим.

txt (они же всё же работают как террористы). Следует иметь в виду, что, хотя большинство роботов будут использовать указания, представленные в этом файле, но вы не можете принудить их это делать. Мы просто хорошо просим.

Если глубже вникнуть в тему, вы найдёте много предложений того, что разрешать и что блокировать на своём сайте WordPress. Хотя, из нашего опыта, меньше правил часто лучше. Вот пример рекомендованного вида вашего первого файла robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/

Традиционно WordPress любит закрывать каталоги wp-admin и wp-includes. Однако, это уже не является лучшим решением. Плюс, если вы добавляете мета тэги для своих изображений с целью продвижения (SEO), нету смысла указывать ботам не отслеживать содержимое этих каталогов. Вместо этого, два правила выше обеспечивают основные потребности большинства сайтов.

Что содержится в вашем файле robots. txt будет зависеть от особенностей и потребностей вашего сайта. Поэтому смело проводите больше исследований!

txt будет зависеть от особенностей и потребностей вашего сайта. Поэтому смело проводите больше исследований!

Как создать файл robots.txt для WordPress (3 способа)

Как только вы решили сделать свой файл robots.txt, всё что осталось – это найти способ его создать. Вы можете редактировать robots.txt в WordPress, используя плагин или вручную. В этом разделе мы обучим вас применению двух наиболее популярных плагинов для выполнения этой задачи и обсудим, как создать и загрузить файл вручную. Поехали!

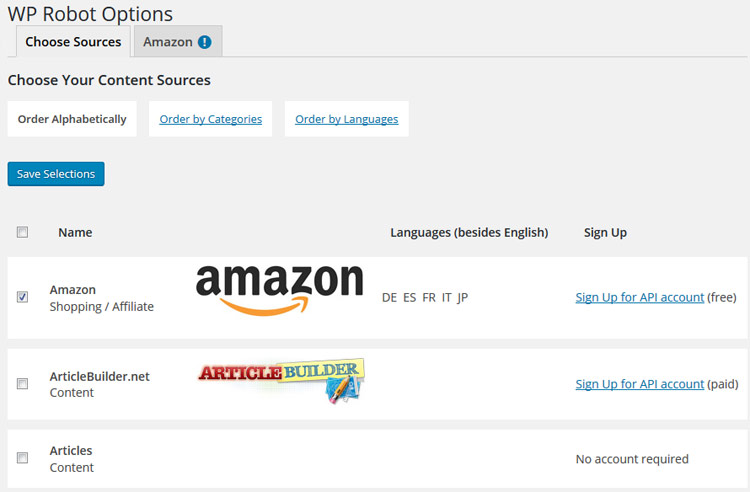

1. Использование плагина Yoast SEO

Yoast SEO вряд ли требует представления. Это наиболее известный SEO-плагин для WordPress, он позволяет вам улучшать ваши записи и страницы для лучшего использования ключевых слов. Кроме этого, он также оценит ваш контент с точки зрения удобности чтения, а это повысит аудиторию поклонников.

Наша команда является почитателями плагина Yoast SEO благодаря его простоте и удобству. Это относится и к вопросу создания файла robots. txt. Как только вы установите и активируете свой плагин, перейдите во вкладку SEO › Инструменты в своей консоли и найдите настройку Редактор файлов:

txt. Как только вы установите и активируете свой плагин, перейдите во вкладку SEO › Инструменты в своей консоли и найдите настройку Редактор файлов:

Нажав на эту ссылку, вы можете редактировать файл .htaccess не покидая админ консоль. Здесь же есть кнопка Создать файл robots.txt:

После нажатия на кнопку во вкладке будет отображён новый редактор, где вы можете напрямую редактировать ваш файл robots.txt. Обратите внимание, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots.txt.

После удаления или добавления правил нажимайте кнопку Сохранить изменения в robots.txt для вступления их в силу:

Это всё! Давайте теперь посмотрим на другой популярный плагин, который позволит нам выполнить эту же задачу.

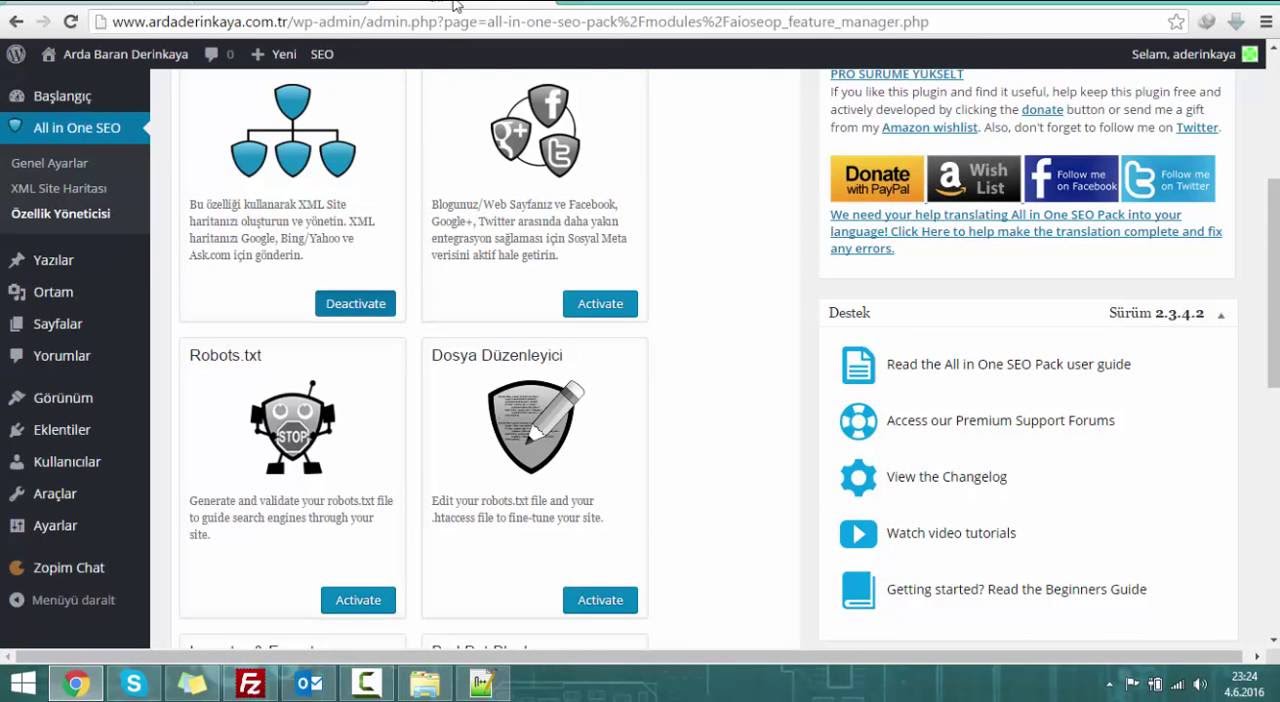

2. Применение плагина All in One SEO Pack

Плагин All in One SEO Pack – ещё один прекрасный плагин WordPress для настройки SEO. Он включает в себя большинство функций плагина Yoast SEO, но некоторые предпочитают его потому что он более легковесный. Что касается файла robots.txt, его создать в этом плагине также просто.

Он включает в себя большинство функций плагина Yoast SEO, но некоторые предпочитают его потому что он более легковесный. Что касается файла robots.txt, его создать в этом плагине также просто.

После установки плагина, перейдите на страницу All in One SEO > Управление модулями в консоли. Внутри вы найдёте опцию Robots.txt с хорошо заметной кнопкой Activate внизу справа. Нажмите на неё:

Теперь в меню All in One SEO будет отображаться новая вкладка Robots.txt. Если вы нажмёте на этот пункт меню, вы увидите настройки для добавления новых правил в ваш файл, сохраните внесённые изменения или удалите всё:

Обратите внимание, что вы не можете напрямую изменять файл robots.txt при помощи этого плагина. Содержимое файла будет неактивным, что видно по серому фону поля, в отличие от Yoast SEO, который позволяет вам вводить всё, что вы хотите:

Но, так как добавление новых правил очень простая процедура, то этот факт не должен расстроить вас. Более важный момент, что All in One SEO Pack также включает функцию, которая поможет вам блокировать «плохих» ботов, её вы можете найти во вкладке All in One SEO:

Более важный момент, что All in One SEO Pack также включает функцию, которая поможет вам блокировать «плохих» ботов, её вы можете найти во вкладке All in One SEO:

Это всё, что вам нужно сделать, если вы выбрали этот способ. Теперь давайте поговорим о том, как вручную создать файл robots.txt, если вы не хотите устанавливать дополнительный плагин только для этой задачи.

3. Создание и загрузка файла

robots.txt для WordPress по FTP

Что может быть проще, чем создание текстового файла txt. Всё, что вам нужно сделать, открыть свой любимый редактор (как, например, Notepad или TextEdit) и ввести несколько строк. Потом вы сохраняете файл, используя любое имя и расширение txt. Это буквально займёт несколько секунд, поэтому вы вполне можете захотеть создать robots.txt для WordPress без использования плагина.

Вот быстрый пример такого файла:

Мы сохранили этот файл локально на компьютере. Как только вы сделали свой собственный файл вам нужно подключиться к своему сайту по FTP. Если вы не совсем понимаете, как это сделать, у нас есть руководство, посвящённое этому – использование удобного для новичков клиента FileZilla.

Как только вы сделали свой собственный файл вам нужно подключиться к своему сайту по FTP. Если вы не совсем понимаете, как это сделать, у нас есть руководство, посвящённое этому – использование удобного для новичков клиента FileZilla.

После подключения к своему сайту перейдите в каталог public_html. Теперь, всё что вам нужно сделать это загрузить файл robots.txt со своего компьютера на сервер. Вы можете это сделать либо нажав правой кнопкой мыши на файле в локальной FTP навигаторе или простым перетаскиванием мышью:

Это займёт всего несколько секунд. Как вы видите, этот способ не сложнее использования плагина.

Как проверит WordPress robots.txt и отправить его в Консоль Google Search

Теперь, когда ваш файл WordPress robots.txt создан и загружен на сайт, вы можете проверить его на ошибки в Консоли Google Search. Search Console – это набор инструментов Google, призванных помочь вам отслеживать то, как ваш контент появляется в результатах поиска. Один из таких инструментов проверяет robots.txt, его вы можете использовать перейдя в своей консоли в раздел Инструмент проверки файла robots.txt:

Один из таких инструментов проверяет robots.txt, его вы можете использовать перейдя в своей консоли в раздел Инструмент проверки файла robots.txt:

Здесь вы найдёте поле редактора, где вы можете добавить код своего файла WordPress robots.txt, и нажать Отправить в правом нижнем углу. Консоль Google Search спросит вас, хотите ли вы использовать новый код или загрузить файл с вашего сайта. Выберите опцию, которая говорит Ask Google to Update для публикации вручную:

Теперь платформа проверит ваш файл на ошибки. Если будет найдена ошибка, информация об этом будет показана вам.

Вы ознакомились с несколькими примерами файл robots.txt WordPress, и теперь у вас есть ещё больше шансов создать свой идеальный!

Заключение

Чтобы быть уверенным, что ваш сайт представлен наилучшим образом для поисковых роботов стоит позаботиться о том, чтобы для них был открыт необходимый контент. Как мы увидели, хорошо настроенный файл robots.txt WordPress поможет показать роботам, каким образом лучше взаимодействовать с вашим сайтом. Таким образом, они помогут тем, кто ищет получить более релевантный и полезный контент.

Как мы увидели, хорошо настроенный файл robots.txt WordPress поможет показать роботам, каким образом лучше взаимодействовать с вашим сайтом. Таким образом, они помогут тем, кто ищет получить более релевантный и полезный контент.

У вас остались вопросы о том, как редактировать robots.txt в WordPress? Напишите нам в разделе комментариев ниже!

Елена имеет профессиональное техническое образование в области информационных технологий и опыт программирования на разных языках под разные платформы и системы. Более 10 лет посвятила сфере веб, работая с разными CMS, такими как: Drupal, Joomla, Magento и конечно же наиболее популярной в наши дни системой управления контентом – WordPress. Её статьи всегда технически выверены и точны, будь то обзор для WordPress или инструкции по настройке вашего VPS сервера.

Что такое robots.txt и как его настроить

Знание о том, что такое robots.txt, и умение с ним работать больше относится к профессии вебмастера. Однако SEO-специалист — это универсальный мастер, который должен обладать знаниями из разных профессий в сфере IT. Поэтому сегодня разбираемся в предназначении и настройке файла robots.txt.

Однако SEO-специалист — это универсальный мастер, который должен обладать знаниями из разных профессий в сфере IT. Поэтому сегодня разбираемся в предназначении и настройке файла robots.txt.

По факту robots.txt — это текстовый файл, который управляет доступом к содержимому сайтов. Редактировать его можно на своем компьютере в программе Notepad++ или непосредственно на хостинге.

Что такое robots.txt

Представим robots.txt в виде настоящего робота. Когда в гости к вашему сайту приходят поисковые роботы, они общаются именно с robots.txt. Он их встречает и рассказывает, куда можно заходить, а куда нельзя. Если вы дадите команду, чтобы он никого не пускал, так и произойдет, т.е. сайт не будет допущен к индексации.

Если на сайте нет этого файла, создаем его и загружаем на сервер. Его несложно найти, ведь его место в корне сайта. Допишите к адресу сайта /robots.txt и вы увидите его.

Зачем нам нужен этот файл

Если на сайте нет robots. txt, то роботы из поисковых систем блуждают по сайту как им вздумается. Роботы могут залезть в корзину с мусором, после чего у них создастся впечатление, что на вашем сайте очень грязно. robots.txt скрывает от индексации:

txt, то роботы из поисковых систем блуждают по сайту как им вздумается. Роботы могут залезть в корзину с мусором, после чего у них создастся впечатление, что на вашем сайте очень грязно. robots.txt скрывает от индексации:

- дубли страниц;

- служебные файлы;

- файлы, которые бесполезны для посетителей;

- страницы с неуникальным контентом.

Правильно заполненный файл robots.txt создает иллюзию, что на сайте всегда чисто и убрано.

Настройка директивов robots.txt

Директивы — это правила для роботов. И эти правила пишем мы.

User-agent

Главное правило называется User-agent. В нем мы создаем кодовое слово для роботов. Если робот видит такое слово, он понимает, что это правило для него.

Пример:

User-agent: Yandex

Данное правило смогут понять только те роботы, которые работают в Яндексе. В последнее время эту строчку я заполняю так:

User-agent: *

Правило понимает Яндекс и Гугл.:format(png)/cdn.vox-cdn.com/uploads/chorus_image/image/49654113/Screen_Shot_2016-05-22_at_11.00.06_AM.0.0.png) Доля трафика с других поисковиков очень мала, и продвигаться в них не стоит затраченных усилий.

Доля трафика с других поисковиков очень мала, и продвигаться в них не стоит затраченных усилий.

Disallow и Allow

С помощью Disallow мы скрываем каталоги от индексации, а, прописывая правило с директивой Allow, даем разрешение на индексацию.

Пример:

Allow: /category/

Даем рекомендацию, чтобы индексировались категории.

Disallow: /

А вот так от индексации будет закрыт весь сайт.

Также существуют операторы, которые помогают уточнить наши правила.

- * – звездочка означает любую последовательность символов (либо отсутствие символов).

- $ – знак доллара является своеобразной точкой, которая прерывает последовательность символов.

Disallow: /category/$ # закрываем только страницу категорий Disallow: /category/* # закрываем все страницы в папке категории

Sitemap

Данная директива нужна для того, чтобы сориентировать робота, если он заплутает. Мы показываем роботу дорогу к Sitemap.

Мы показываем роботу дорогу к Sitemap.

Пример:

Sitemap: http://site.ru/sitemap.xml

Директива host уже устарела, поэтому о ней говорить не будем.

Crawl-delay

Если сайт небольшой, то директиву Crawl-delay заполнять нет необходимости. Эта директива нужна, чтобы задать периодичность скачивания документов с сайта.

Пример:

Crawl-delay: 10

Это правило означает, что документы с сайта будут скачиваться с интервалом в 10 секунд.

Clean-param

Директива Clean-param закрывает от индексации дубли страниц с разными адресами. Например, если вы продвигаетесь через контекстную рекламу, на сайте будут появляться страницы с utm-метками. Чтобы подобные страницы не плодили дубли, мы можем закрыть их с помощью данной директивы.

Пример:

Clean-Param: utm_source&utm_medium&utm_campaign

Как закрыть сайт от индексации

Чтобы полностью закрыть сайт от индексации, достаточно прописать в файле следующее:

User-agent: * Disallow: /

Если требуется закрыть от поисковиков поддомен, то нужно помнить, что каждому поддомену требуется свой robots. txt. Добавляем файл, если он отсутствует, и прописываем магические символы.

txt. Добавляем файл, если он отсутствует, и прописываем магические символы.

Проверка файла robots

Есть потрясающий инструмент, который позволит вам включиться в творческую работу с директивами и прописать правильный robots.txt – инструмент от Яндекс.Вебмастера.

Переходим в инструмент, вводим домен и содержимое вашего файла.

Нажимаем «Проверить» и получаем результаты анализа. Здесь мы можем увидеть, есть ли ошибки в нашем robots.txt.

Но на этом функции инструмента не заканчиваются. Вы можете проверить, разрешены ли определенные страницы сайта для индексации или нет.

Вводим список адресов, которые нас интересуют, и нажимаем «Проверить». Инструмент сообщит нам, разрешены ли для индексации данные адреса страниц, а в столбце «Результат» будет видно, почему страница индексируется или не индексируется.

Здесь вас ждет простор для творчества. Пользуйтесь звездочкой или знаком доллара и закрывайте от индексации страницы, которые не несут пользы для посетителей. Будьте внимательны – проверяйте, не закрыли ли вы от индексации важные страницы.

Будьте внимательны – проверяйте, не закрыли ли вы от индексации важные страницы.

Правильный robots.txt для WordPress

Кстати, если вы поставите #, то сможете оставлять комментарии, которые не будут учитываться роботами.

User-agent: * Disallow: /cgi-bin # папка на хостинге Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ # Все служебные файлы можно закрыть другим образом: Disallow: /wp- Disallow: /xmlrpc.php # файл WordPress API Disallow: /*? # поиск Disallow: /?s= # поиск Allow: /*.css # стили Allow: /*.js # скрипты Sitemap: https://site.ru/sitemap.xml # путь к карте сайта (надо прописать свой сайт)

Правильный robots.txt для Joomla

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/ Sitemap: https://site.ru/sitemap.xml

Здесь указаны другие названия директорий, но суть одна: закрыть мусорные и служебные страницы, чтобы показать поисковиками только то, что они хотят увидеть.

Правильно настроенный файл robots.txt способен оказать позитивное влияние на продвижение сайта. Если вы хотите избавиться от мусора и навести порядок на сайте, файл robots.txt готов прийти на помощь.

Правильный файл robots.txt для WordPress (2020) — Robots.Txt по-русски

Файл robots.txt для WordPress (WP)

Приводим два варианта файла robots.txt для WordPress: стандартный и расширенный. Стандартный не содержит отдельные блоки для поисковых ботов Google и Яндекса. Расширенный уже менее актуален, т.к. теперь нет принципиальных различий между поисковыми системами Яндекс и Google: обеим системам нужно индексировать файлы скриптов и изображений, обе не поддерживают директиву Host.

Стандартный вариант

User-agent: *

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

Host: www.site.ru

Расширенный вариант

User-agent: *

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploadsUser-agent: GoogleBot

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.phpUser-agent: Yandex

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign

Clean-Param: openstatSitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gzHost: www.site.

ru

Важная информация:

Директива Host — игнорируется Яндексом. Теперь это делается при помощи редиректа.

Директива Crawl-delay — игнорируется Яндексом. Теперь что бы ограничить скорость необходимо в Яндекс.Вебмастер воспользоваться инструментом «Скорость обхода» в раздел «Индексирование».

Как сделать robots.txt для WordPress.Создаем правильный robots.txt для сайта на WordPress

Приветствую, друзья! В этом уроке мы поговорим о создании файла robots.txt, который показывает роботам поисковых систем, какие разделы Вашего сайта нужно посещать, а какие нет.

Фактически, с помощью этого служебного файла можно указать, какие разделы будут индексироваться в поисковых системах, а какие нет.

Создание файла robots.txt

1. Создайте обычный текстовый файл с названием robots в формате .txt.

2. Добавьте в него следующую информацию :

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= Host: site.com Sitemap: http://site.com/sitemap.xml

3. Замените в в текстовом файле строчку site.com на адрес Вашего сайта.

4. Сохраните изменения и загрузите файл robots.txt (с помощью FTP) в корневую папку Вашего сайта.

5. Готово.

Для просмотра и скачки примера, нажмите кнопку ниже и сохраните файл (Ctrl + S на клавиатуре).

Скачать пример файла robots.txt

Разбираемся в файле robots.txt (директивы)

Давайте теперь более детально разберем, что именно и зачем мы добавили в файл robots. txt.

txt.

User-agent — директива, которая используется для указания названия поискового робота. С помощью этой директивы можно запретить или разрешить поисковым роботам посещать Ваш сайт. Примеры:

Запрещаем роботу Яндекса просматривать папку с кэшем:

User-agent: Yandex Disallow: /wp-content/cache

Разрешаем роботу Bing просматривать папку themes (с темами сайта):

User-agent: bingbot Allow: /wp-content/themes

Allow и Disallow — разрешающая и запрещающая директива. Примеры:

Разрешим боту Яндекса просматривать папку wp-admin:

User-agent: Yandex Allow: /wp-admin

Запретим всем ботам просматривать папку wp-content:

User-agent: * Disallow: /wp-content

В нашем robots.txt мы не используем директиву Allow, так как всё, что не запрещено боту с помощью Disallow — по умолчанию будет разрешено.

Host — директива, с помощью которой нужно указать главное зеркало сайта, которое и будет индексироваться роботом.

Sitemap — используя эту директиву, нужно указать путь к карте сайта. Напомню, что карта сайта является очень важным инструментом при продвижении сайта! Обязательно указывайте её в этой директиве!

Если остались какие-то вопросы — задавайте их в комментарий. Если же информации в этом уроке для Вас оказалось недостаточно, рекомендую почитать подробнее о всех директивах и способах их использования перейдя по этой ссылке.

Приветствую, друзья! В этом уроке мы поговорим о создании файла robots.txt, который показывает роботам поисковых систем, какие разделы Вашего сайта нужно посещать, а какие нет. Фактически, с помощью этого служебного файла можно указать, какие разделы будут индексироваться в поисковых системах, а какие нет. Создание файла robots.txt 1. Создайте обычный текстовый файл с названием robots в формате .txt. 2. Добавьте в него следующую информацию : User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes…

2. Добавьте в него следующую информацию : User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes…

Создание и настройка robots.txt

Рейтинг: 4.51 ( 33 голосов )

100

Правильный robots.txt для WordPress

Относительно того, что должно быть внутри файла robots.txt до сих пор возникает куча споров. Вообще, на мой взгляд, этот файл должен содержать две обязательные вещи:

Скрывать в нём все функциональные PHP-файлы (как делают некоторые вебмастера) я не вижу смысла. А уж страницы сайта тем более. Я проводил эксперимент со скрытием страниц через robots. — они всё равно попали в индекс, но только без заголовка и без сниппета. txt

txt

Для скрытия от индексации страниц сайта используйте метатег:

<meta name="robots" content="noindex, follow" />

Функция do_robots()

Выводит несколько директив для файла robots.txt, рекомендуемые для WordPress.

Параметров не имеет, зато имеет 1 хук и 1 фильтр.

Рассмотрим по порядку, как работает функция:

- В первую очередь функция устанавливает

Content-Typeдокумента наtext/plain(с кодировкой UTF-8). - Затем запускается экшен

do_robotstxt(без параметров). - Третьим шагом идёт проверка, отмечена ли галочка «Попросить поисковые системы не индексировать сайт» в настройках чтения:

- Если отмечена, содержимое

robots.txtбудет:User-agent: * Disallow: /

Если не отмечена:

User-agent: * Disallow: /wp-admin/

- Непосредственно перед выводом срабатывает фильтр

robots_txt(WordPress 3. 0+) с двумя параметрами —

0+) с двумя параметрами — $output(то, что подготовлено для вывода вrobots.txt) и$public(отмечена ли галочка в пункте 3).

Готовый robots.txt

К результату функции do_robots() добавим еще то, о чем я говорил в начале поста и получим вот такой robots.txt для WordPress:

User-agent: * Disallow: /wp-admin/ User-agent: Yandex Disallow: /wp-admin/ Host: truemisha.ru Sitemap: https://misha.agency/sitemap.xml

Создать его вы можете при помощи любого текстового редактора. Сохраните его там же, где находятся директории wp-admin и wp-content.

Миша

Впервые познакомился с WordPress в 2009 году. Организатор и спикер на конференциях WordCamp. Преподаватель в школах Epic Skills и LoftSchool.

Если вам нужна помощь с сайтом или разработка с нуля на WordPress / WooCommerce — пишите. Я и моя команда будем рады вам помочь!

Virtual Robots.

txt — Плагин для WordPress

txt — Плагин для WordPress

Virtual Robots.txt is an easy (i.e. automated) solution to creating and managing a robots.txt file for your site. Instead of mucking about with FTP, files, permissions ..etc, just upload and activate the plugin and you’re done.

By default, the Virtual Robots.txt plugin allows access to the parts of WordPress that good bots like Google need to access. Other parts are blocked.

If the plugin detects an existing XML sitemap file, a reference to it will be automatically added to your robots.txt file.

- Upload pc-robotstxt folder to the

/wp-content/plugins/directory - Активируйте плагин используя меню ‘Плагины’ в WordPress.

- Once you have the plugin installed and activated, you’ll see a new Robots.txt menu link under the Settings menu. Click that menu link to see the plugin settings page. From there you can edit the contents of your robots.txt file.

Will it conflict with an existing robots.

txt file?

txt file?If a physical robots.txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

Will this work for sub-folder installations of WordPress?

Out of the box, no. Because WordPress is in a sub-folder, it won’t «know» when someone is requesting the robots.txt file which must be at the root of the site.

Does this plugin modify individual posts, pages, or categories?

No it doesn’t.

Why does the default plugin block certain files and folders?

By default, the virtual robots.txt is set to block WordPress files and folders that don’t need to be accessed by search engines. Of course, if you disagree with the defaults, you can easily change them.

Works great and easy to use and customise. It already set by default the directories that need to be left out of Search Engines scanning/indexing. ..

..

Very happy with it!

What I saw wasn’t what I got. The XML sitemap wasn’t included in the robots.txt file, even thought this was described as a feature that should work out of the box. In addition to that, upon installing this plugin, it blocked certain directories without asking. Lastly, it inserts a line at the top of the file, promoting the plugin. That should be an optional feature that users are empowered to turn off. All in all, it offers the functionality, but falls short and disappoints in other areas.

I thought this would be simple. Sure sounds simple.

But after I saved your suggested text to my brand new «virtual robots.txt», I clicked the link where it says «You can preview your robots.txt file here (opens a new window). If your robots.txt file doesn’t match what is shown below, you may have a physical file that is being displayed instead.»

That new window shows text that is indeed different from the plugin’s. So I understand that to mean there’s a physical robots.txt file on my server.

So which one is actually going to be used?

Your FAQ offers this:

Q: Will it conflict with any existing robots.txt file?

A: If a physical robots.txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

If a physical file exists, WP won’t process ANY request for one?

This SOUNDS like WP will ignore BOTH the physical file AND your virtual one. In which case, what’s the point? Might as well not have one, it seems to me.

When I manually go to mydomain.com/robots.txt, I see what’s in the physical file, not what the plugin saved.

So… is it working? I don’t know!

Should I delete the physical file and assume the virtual one will work? I don’t know!

Should I delete this plugin and edit the physical file manually? Most likely.

2 stars instead of 1 because I appreciate getting the suggested lines to include in my file.

I like the fact that it’s so clean. Thanks for building it!

Awesome, a simple solution to a common issue (site content managers who want to hide certain pages from Google search results).

Just a little note: in my case, the existing Sitemap created by the plugin «Google (XML) Sitemaps Generator» by Arne Brachhold wasn’t detected.

Посмотреть все 7 отзывов

«Virtual Robots.txt» — проект с открытым исходным кодом. В развитие плагина внесли свой вклад следующие участники:

Участники

1.10

- Fix to prevent the saving of HTML tags within the robots.txt form field. Thanks to TrustWave for identifying this issue.

1.9

- Fix for PHP 7. Thanks to SharmPRO.

1.8

- Undoing last fixes as they had unintended side-effects.

1.7

- Further fixes to issue with newlines being removed. Thanks to FAMC for reporting and for providing the code fix.

- After upgrading, visit and re-save your settings and confirm they look correct.

1.6

- Fixed bug where newlines were being removed. Thanks to FAMC for reporting.

1.5

- Fixed bug where plugin assumed robots.txt would be at http when it may reside at https. Thanks to jeffmcneill for reporting.

1.4

- Fixed bug for link to robots.txt that didn’t adjust for sub-folder installations of WordPress.

- Updated default robots.txt directives to match latest practices for WordPress.

- Plugin development and support transferred to Marios Alexandrou.

1.3

- Now uses do_robots hook and checks for is_robots() in plugin action.

1.2

- Added support for existing sitemap.xml.gz file.

1.1

- Added link to settings page, option to delete settings.

1.0

- Первая версия.

Robots.txt и WordPress | WP Engine®

Поддержание поисковой оптимизации (SEO) вашего сайта имеет решающее значение для привлечения органического трафика. Однако есть некоторые страницы, такие как дублированный контент или промежуточные области, которые вы можете не захотеть, чтобы пользователи находили через поисковые системы. К счастью, есть способ запретить таким системам, как Google, получать доступ к определенным страницам и отображать их для поисковиков. Редактируя файл robots.txt своего сайта, вы можете контролировать, какой контент будет отображаться на страницах результатов поиска (SERP).

ПРИМЕЧАНИЕ. По умолчанию WP Engine ограничивает трафик поисковых систем на любой сайт, использующий среду , домен .wpengine.com . Это означает, что поисковые системы не смогут посещать сайты , а не , которые в настоящее время находятся в разработке, с использованием личного домена.

О

Robots.txt

Файл robots.txt содержит инструкции для поисковых систем о том, как находить и извлекать информацию с вашего веб-сайта.Этот процесс называется «сканированием». После того, как страница просканирована, она будет проиндексирована, чтобы поисковая система могла быстро найти и отобразить ее позже.

Первое, что делает сканер поисковой системы, когда попадает на сайт, — это ищет файл robots.txt . Если его нет, он продолжит сканирование остальной части сайта в обычном режиме. Если он найдет этот файл, сканер будет искать в нем какие-либо команды, прежде чем продолжить.

В роботе есть четыре общие команды.txt файл:

-

Disallowзапрещает сканерам поисковых систем проверять и индексировать указанные файлы сайта. Это может помочь вам предотвратить появление в поисковой выдаче дублированного контента, промежуточных областей или других личных файлов. -

Разрешитьразрешает доступ к подпапкам, в то время как родительские папки запрещены. -

Crawl-delayпредписывает поисковым роботам подождать определенное время перед загрузкой файла. -

Sitemapуказывает расположение любых файлов Sitemap, связанных с вашим сайтом.

Файлы Robots.txt всегда форматируются одинаково, чтобы их директивы были понятны:

Каждая директива начинается с идентификации агента пользователя , который обычно является сканером поисковой системы. Если вы хотите, чтобы команда применялась ко всем потенциальным пользовательским агентам, вы можете использовать звездочку * . Чтобы вместо этого настроить таргетинг на определенный пользовательский агент, вы можете добавить его имя. Например, мы могли бы заменить звездочку выше на Googlebot , чтобы запретить Google сканирование страницы администратора.

Понимание того, как использовать и редактировать файл robots.txt , имеет жизненно важное значение. Включенные в него директивы будут определять, как поисковые системы взаимодействуют с вашим сайтом. Они могут помочь вам, скрывая контент, от которого вы хотите отвлечь пользователей, что улучшит общее SEO вашего сайта.

Протестируйте файл

Robots.txt Файл

Вы можете проверить, есть ли у вас файл robots.txt , добавив /robots.txt в конец URL-адреса вашего сайта в браузере (Пример: https: // wpengine.com / robots.txt ). Это вызовет файл, если он существует. Однако наличие вашего файла не обязательно означает, что он работает правильно.

К счастью, проверить файл robots.txt просто. Вы можете просто скопировать и вставить свой файл в тестер robots.txt. Инструмент выделит все ошибки в файле. Важно отметить, что изменения, внесенные в редактор robots.txt тестера, не будут применяться к фактическому файлу — вам все равно придется отредактировать файл на своем сервере.

Некоторые распространенные ошибки включают запрет на использование файлов CSS или JavaScript, неправильное использование подстановочных знаков, таких как * и долларов США, а также случайное запрещение важных страниц. Также важно помнить, что сканеры поисковых систем чувствительны к регистру, поэтому все URL-адреса в файле robots.txt должны отображаться так же, как и в вашем браузере.

Создание файла

Robots.txt с подключаемым модулем

Если на вашем сайте не хватает файла robots.txt , вы можете легко добавить его в WordPress с помощью плагина Yoast SEO. Это избавит вас от необходимости создавать простой текстовый файл и вручную загружать его на сервер. Если вы предпочитаете создать его вручную, перейдите к разделу «Создание файла Robots.txt вручную» ниже.

Перейдите к инструментам Yoast SEO

Для начала вам потребуется установить и активировать плагин Yoast SEO. Затем вы можете перейти на панель администратора WordPress и выбрать SEO > Tools на боковой панели :

.

Это приведет вас к списку полезных инструментов, к которым пользователи Yoast могут получить доступ для эффективного улучшения своего SEO.

Использование редактора файлов для создания файла

Robots.txt

Одним из инструментов, доступных в списке, является редактор файлов. Это позволяет вам редактировать файлы, связанные с SEO вашего сайта, в том числе файл robots.txt :

Поскольку на вашем сайте его еще нет, выберите Создать файл robots.txt :

Откроется редактор файлов, в котором вы сможете редактировать и сохранять новый файл.

Измените роботов

по умолчанию.txt и сохраните его

По умолчанию новый файл robots.txt , созданный с помощью Yoast, включает директиву, скрывающую вашу папку wp-admin и разрешающую доступ к вашему файлу admin-ajax.php для всех пользовательских агентов. Рекомендуется оставить эту директиву в файле:

Перед сохранением файла вы также можете добавить любые другие директивы, которые хотите включить. В этом примере мы запретили поисковым роботам Bing доступ ко всем нашим файлам, добавили задержку сканирования в десять миллисекунд для поискового робота Yahoo Slurp и направили поисковые роботы в расположение нашей карты сайта.Когда вы закончите вносить свои изменения, не забудьте их сохранить!

Руководство

Robots.txt Создание файла

Если вам нужно создать файл robots.txt вручную, процесс так же прост, как создание и загрузка файла на ваш сервер.

- Создайте файл с именем

robots.txt- Убедитесь, что имя написано в нижнем регистре.

- Убедитесь, что расширение —

.txt, а не.html

- Добавьте в файл любые необходимые директивы и сохранить

- Загрузите файл с помощью SFTP или SSH-шлюза в корневой каталог вашего сайта

ПРИМЕЧАНИЕ : Если в корне вашего сайта есть физический файл с именем robots.txt , он перезапишет любой динамически сгенерированный файл robots.txt , созданный плагином или темой.

Использование файла robots.txt

Файл robots.txt разбивается на блоки пользовательским агентом. Внутри блока каждая директива указывается в новой строке. Например:

Агент пользователя: * Запретить: / Пользовательский агент: Googlebot Запретить: Пользовательский агент: bingbot Запретить: / no-bing-crawl / Запрещено: wp-admin

Пользовательские агенты обычно сокращаются до более общего имени, но это не требуется .

Значения директивы чувствительны к регистру.

- URL-адреса

no-bing-crawlиNo-Bing-Crawl— это разных .

Глобализация и регулярные выражения не поддерживаются полностью .

-

*в поле User-agent — это специальное значение, означающее «любой робот».

Ограничить доступ всех ботов к вашему сайту

(Все сайты в среде .wpengine.com , автоматически применяется следующий файл robots.txt .)

Агент пользователя: * Disallow: /

Ограничить доступ одного робота ко всей площадке

Агент пользователя: BadBotName Disallow: /

Ограничить доступ ботов к определенным каталогам и файлам

Пример запрещает ботов на всех страницах wp-admin и wp-login.php . Это хороший стандартный или начальный роботов.txt файл.

Агент пользователя: * Запретить: / wp-admin / Запрещено: /wp-login.php

Ограничить доступ бота ко всем файлам определенного типа

В примере используется тип файла .pdf

Агент пользователя: * Disallow: /*.pdf$

Ограничить конкретную поисковую систему

Пример использования Googlebot-Image в / wp-content / загружает каталог

User-Agent: Googlebot-Image Запретить: / wp-content / uploads /

Ограничить всех ботов, кроме одного

Пример разрешает только Google

Пользовательский агент: Google Запретить: Пользовательский агент: * Disallow: /

Добавление правильных комбинаций директив может быть сложным.К счастью, есть плагины, которые также создают (и тестируют) файл robots.txt за вас. Примеры плагинов:

Если вам нужна дополнительная помощь в настройке правил в файле robots.txt, мы рекомендуем посетить Google Developers или The Web Robots Pages для получения дополнительных инструкций.

Задержка сканирования

Если вы видите слишком высокий трафик ботов и это влияет на производительность сервера, задержка сканирования может быть хорошим вариантом. Задержка сканирования позволяет ограничить время, которое должен пройти бот перед сканированием следующей страницы.

Для настройки задержки сканирования используйте следующую директиву, значение настраивается и указывается в секундах:

задержка сканирования: 10

Например, чтобы запретить сканирование всем ботам wp-admin , wp-login.php и установить задержку сканирования для всех ботов на 600 секунд (10 минут):

Агент пользователя: * Запретить: /wp-login.php Запретить: / wp-admin / Задержка сканирования: 600

ПРИМЕЧАНИЕ : Службы обхода контента могут иметь свои собственные требования для установки задержки обхода.Как правило, лучше всего напрямую связаться со службой для получения требуемого метода.

Отрегулируйте задержку сканирования для SEMrush

- SEMrush — отличный сервис, но сканирование может быть очень тяжелым, что в конечном итоге снижает производительность вашего сайта. По умолчанию боты SEMrush игнорируют директивы задержки сканирования в вашем файле robots.txt, поэтому обязательно войдите в их панель управления и включите Уважение задержки сканирования robots.txt .

- Более подробную информацию о SEMrush можно найти здесь.

Настроить задержку сканирования Bingbot

- Bingbot должен соблюдать директивы

crawl-delay, однако они также позволяют вам установить шаблон управления сканированием.

Настройте задержку сканирования для Google

Подробнее см. В документации поддержки Google)

Откройте страницу настроек скорости сканирования вашего ресурса.

- Если ваша скорость сканирования описана как , рассчитанная как оптимальная , единственный способ уменьшить скорость сканирования — это подать специальный запрос.Вы не можете увеличить скорость сканирования .

- В противном случае , выберите нужный вариант и затем ограничьте скорость сканирования по желанию. Новая скорость сканирования будет действовать в течение 90 дней.

ПРИМЕЧАНИЕ . Хотя эта конфигурация запрещена на нашей платформе, стоит отметить, что задержка сканирования Googlebot не может быть изменена для сайтов, размещенных в подкаталогах, таких как domain.com/blog .

Лучшие Лрактики

Прежде всего следует помнить о следующем: непроизводственные сайты должны запрещать использование всех пользовательских агентов.WP Engine автоматически делает это для любых сайтов, использующих домен environmentname .wpengine.com . Только когда вы будете готовы «запустить» свой сайт, вы можете добавить файл robots.txt .

Во-вторых, если вы хотите заблокировать определенного User-Agent, помните, что роботы не обязаны следовать правилам, установленным в вашем файле robots.txt . Лучшей практикой было бы использовать брандмауэр, такой как Sucuri WAF или Cloudflare, который позволяет вам блокировать злоумышленников до того, как они попадут на ваш сайт.Или вы можете обратиться в службу поддержки за дополнительной помощью по блокировке трафика.

Наконец, если у вас очень большая библиотека сообщений и страниц на вашем сайте, Google и другие поисковые системы, индексирующие ваш сайт, могут вызвать проблемы с производительностью. Увеличение срока действия кеша или ограничение скорости сканирования поможет компенсировать это влияние.

СЛЕДУЮЩИЙ ШАГ: устранение ошибок 504

Передовой пример для SEO • Yoast

Джоно Алдерсон

Джоно — цифровой стратег, технолог по маркетингу и разработчик полного цикла.Он занимается техническим SEO, новыми технологиями и стратегией бренда.

Файл robots.txt — мощный инструмент, когда вы работаете над поисковой оптимизацией веб-сайта, но с ним следует обращаться осторожно. Он позволяет запрещать поисковым системам доступ к различным файлам и папкам, но часто , а не — лучший способ оптимизировать ваш сайт. Здесь мы объясним, как, по нашему мнению, веб-мастера должны использовать свой файл robots.txt, и предложим «передовой» подход, подходящий для большинства веб-сайтов.

Ниже на этой странице вы найдете пример robots.txt, который работает для подавляющего большинства веб-сайтов WordPress. Если вы хотите узнать больше о том, как работает ваш файл robots.txt, вы можете прочитать наше полное руководство по robots.txt.

Как выглядит «передовая практика»?

Поисковые системы постоянно улучшают способы сканирования Интернета и индексации контента. Это означает, что то, что считалось оптимальным несколько лет назад, больше не работает или даже может нанести вред вашему сайту.

Сегодня лучшая практика означает как можно меньше полагаться на файл robots.txt. Фактически, действительно необходимо блокировать URL-адреса в файле robots.txt только тогда, когда у вас есть сложные технические проблемы (например, большой веб-сайт электронной коммерции с фасетной навигацией) или когда нет другого выхода.

Блокировка URL-адресов через robots.txt — это метод «грубой силы», который может вызвать больше проблем, чем решить.

Для большинства сайтов WordPress рекомендуется следующий пример:

# Это поле намеренно оставлено пустым

# Если вы хотите узнать, почему наш robots.txt выглядит так, прочтите этот пост: https://yoa.st/robots-txt

Пользовательский агент: * Мы даже используем этот подход в нашем собственном файле robots.txt.

Что делает этот код?

- Инструкция

User-agent: *утверждает, что все следующие инструкции применимы ко всем поисковым роботам. - Поскольку мы не предоставляем никаких дальнейших инструкций, мы говорим, что «все сканеры могут свободно сканировать этот сайт без ограничений».

- Мы также предоставляем некоторую информацию людям, просматривающим файл (ссылаясь на эту самую страницу), чтобы они понимали, почему файл «пуст».

Если вам нужно запретить URL-адреса

Если вы хотите запретить поисковым системам сканировать или индексировать определенные части вашего сайта WordPress, почти всегда лучше сделать это, добавив метатеги для роботов или для заголовков HTTP для роботов .

В нашем полном руководстве по метатегам роботов объясняется, как «правильно» управлять сканированием и индексированием, а наш плагин Yoast SEO предоставляет инструменты, которые помогут вам реализовать эти теги на своих страницах.

Если у вашего сайта есть проблемы со сканированием или индексированием, которые нельзя решить с помощью метатегов , или HTTP-заголовков , или если вам нужно предотвратить доступ сканеров по другим причинам, вам следует прочитать наше полное руководство по роботам.текст.

Обратите внимание, что WordPress и Yoast SEO уже автоматически предотвращают индексацию некоторых конфиденциальных файлов и URL-адресов, например, вашей административной области WordPress (через HTTP-заголовок x-robots).

Почему этот «минимализм» лучше всего подходит?

Robots.txt создает тупики

Прежде чем вы сможете соревноваться за видимость в результатах поиска, поисковым системам необходимо обнаружить, просканировать и проиндексировать ваши страницы. Если вы заблокировали определенные URL-адреса с помощью robots.txt, поисковые системы больше не смогут сканировать эти страницы с по для обнаружения других.Это может означать, что ключевые страницы не будут обнаружены.

Robots.txt запрещает ссылкам их значение

Одно из основных правил SEO заключается в том, что ссылки с других страниц могут влиять на вашу эффективность. Если URL-адрес заблокирован, поисковые системы не только не будут его сканировать, но и не будут распространять «значение ссылки», указывающее на этот URL-адрес или с по на другие страницы сайта.

Google полностью отображает ваш сайт

Люди раньше блокировали доступ к файлам CSS и JavaScript, чтобы поисковые системы фокусировались на этих важнейших страницах с контентом.

В настоящее время Google извлекает все ваши стили и JavaScript и полностью отображает ваши страницы. Понимание макета и представления вашей страницы является ключевой частью оценки качества. Таким образом, Google совсем не нравится , когда вы запрещаете ему доступ к вашим файлам CSS или JavaScript.

Предыдущая передовая практика блокировки доступа к вашему каталогу wp-includes и каталогу ваших плагинов через файл robots.txt больше не действует, поэтому мы работали с WordPress, чтобы удалить правило disallow по умолчанию для wp-includes в версии 4.0.

Многие темы WordPress также используют асинхронные запросы JavaScript — так называемый AJAX — для добавления содержимого на веб-страницы. WordPress раньше блокировал Google для этого по умолчанию, но мы исправили это в WordPress 4.4.

Вам (обычно) не нужно ссылаться на карту сайта

Стандарт robots.txt поддерживает добавление в файл ссылки на ваши XML-карты сайта. Это помогает поисковым системам обнаруживать местонахождение и содержание вашего сайта.

Нам всегда казалось, что это лишнее; вы уже должны это сделать, добавив карту сайта в свои учетные записи Google Search Console и Bing Webmaster Tools, чтобы получить доступ к аналитике и данным о производительности.Если вы это сделали, то ссылка в файле robots.txt вам не понадобится.

Подробнее: Предотвращение индексации вашего сайта: правильный путь »

Оцените свою техническую пригодность к SEO

Внимательное отношение к вашему файлу robots.txt — важная часть технического SEO. Хотите знать, насколько соответствует техническая SEO вашего сайта? Мы создали технический тест на пригодность для SEO, который поможет вам понять, над чем вам нужно работать!

Далее!

- Событие Конференция онлайн 2021

14-15 октября 2021 г.

Команда Yoast спонсирует онлайн-конференцию 2021 года, нажмите здесь, чтобы узнать, будем ли мы там, кто будет и многое другое!

Все мероприятия, в которых мы будем участвовать » - Вебинар по SEO Вебинар по новостям Yoast в области SEO — 31 августа 2021 года

31 августа 2021 г.

Зарегистрируйтесь на наш веб-семинар по новостям SEO в августе 2021 года.Наши SEO-эксперты Джоно и Джуст расскажут вам о последних новостях Google и WordPress.

Все вебинары Yoast SEO »

Как редактировать robots.txt через Yoast SEO • Yoast

Файл robots.txt сообщает поисковой системе, где разрешено переходить на ваш веб-сайт. Вы можете редактировать файл robots.txt с помощью Yoast SEO и Yoast SEO Premium. В этой статье мы покажем вам, как это сделать!

Хотите узнать больше о том, что такое robots.txt есть и что он делает? Ознакомьтесь с нашим полным руководством по robots.txt.

WordPress по умолчанию

По умолчанию WordPress создает файл robots.txt со следующим содержанием:

Агент пользователя: * Запретить: / wp-admin / Разрешить: /wp-admin/admin-ajax.php

При создании или настройке файла robots.txt это содержимое заменяется.

Создайте или отредактируйте robots.txt в панели управления WordPress

Самый простой способ создать или отредактировать файл robots.txt через Yoast SEO на панели инструментов WordPress. Для этого выполните следующие действия.

- Войдите на свой сайт WordPress.

Когда вы войдете в систему, вы попадете в «Личный кабинет».

- Нажмите «SEO».

Слева вы увидите меню. В этом меню нажмите «SEO».

- Щелкните «Инструменты».

Настройки «SEO» расширятся, предоставляя вам дополнительные возможности. Щелкните «Инструменты».

- Щелкните «Редактор файлов».

Это меню не появится, если в вашей установке WordPress отключено редактирование файлов. Пожалуйста, разрешите редактирование файла или отредактируйте файл через FTP. Если вы не знаете, как использовать FTP, ваш хост-провайдер может помочь.

- Внесите изменения в свой файл.

- Сохраните изменения.

Создайте или отредактируйте на своем сервере

Если файл robots.txt недоступен для записи или ваша установка WordPress отключила редактирование файла, создание или редактирование файла robots.txt через панель управления WordPress может завершиться ошибкой. В этом случае вы можете редактировать на уровне сервера. WordPress генерирует виртуальный файл robots.txt , если корень сайта не содержит физического файла. Чтобы переопределить виртуальный файл, выполните следующие действия, чтобы создать физический файл robots.txt .

- Используйте свой любимый текстовый редактор и создайте текстовый файл.

- Сохраните пустой файл с именем

robots.txt. - Загрузите файл на свой сервер.Если вы не знаете, где на вашем сервере загрузить файл, обратитесь к своему веб-хосту.

Если WordPress блокировал доступ к виртуальному файлу, вы должны иметь возможность редактировать физический файл из нашего плагина. В противном случае вы всегда можете отредактировать robots.txt прямо на своем сервере с помощью FTP или файлового менеджера сервера.

Если у вас возникли проблемы с загрузкой или редактированием файлов на сервере, обратитесь за помощью к своему веб-хосту.

Оптимизация

WordPress Robots.txt (+ XML Sitemap) — посещаемость веб-сайта, поисковая оптимизация и повышение рейтинга — плагин для WordPress

Лучшие роботы.txt создает виртуальный файл robots.txt WordPress, помогает повысить SEO вашего сайта (возможности индексации, рейтинг Google и т. д.) и производительность загрузки — Совместимость с Yoast SEO, Google Merchant, WooCommerce и сетевыми сайтами на основе каталогов (MULTISITE)

С помощью Better Robots.txt вы можете определить, каким поисковым системам разрешено сканировать ваш сайт (или нет), указать четкие инструкции о том, что им разрешено (или нет), и определить задержку сканирования (для защиты вашего хостинг-сервера от агрессивные скребки).Better Robots.txt также дает вам полный контроль над содержимым файла robots.txt WordPress с помощью окна пользовательских настроек.

Уменьшите экологический след вашего сайта и выбросы парниковых газов (CO2), обусловленные его существованием в Интернете.

Краткий обзор:

ПОДДЕРЖИВАЕТСЯ НА 7 ЯЗЫКАХ

Плагины

Better Robots.txt переведены и доступны на следующих языках: китайский — 汉语 / 漢語, английский, французский — Français, русский –Руссɤɢɣ, португальский — Português, испанский — Español, немецкий — Deutsch

Знаете ли вы, что…

- Роботы.txt — это простой текстовый файл, размещаемый на вашем веб-сервере, который сообщает поисковым роботам (например, роботу Google), следует ли им обращаться к файлу.

- Файл robots.txt контролирует, как пауки поисковых систем видят ваши веб-страницы и взаимодействуют с ними;

- Этот файл и боты, с которыми они взаимодействуют, являются фундаментальными частями работы поисковых систем;

- Первое, на что смотрит сканер поисковой системы при посещении страницы, — это файл robots.txt;

Роботы.txt — это источник сока SEO, который только и ждет, чтобы его разблокировали. Попробуйте Better Robots.txt!

О версии Pro (дополнительные возможности):

1. Повысьте свой контент в поисковых системах с помощью карты сайта!

Убедитесь, что ваши страницы, статьи и продукты, даже самые последние, принимаются во внимание поисковыми системами!

Плагин Better Robots.txt был создан для работы с плагином Yoast SEO (вероятно, лучшим плагином SEO для веб-сайтов WordPress).Он определит, используете ли вы в настоящее время Yoast SEO и активирована ли функция карты сайта. Если это так, то он автоматически добавит инструкции в файл Robots.txt, предлагая ботам / сканерам прочитать вашу карту сайта и проверить, внесли ли вы последние изменения на свой сайт (чтобы поисковые системы могли сканировать новый доступный контент).

Если вы хотите добавить свою собственную карту сайта (или если вы используете другой плагин SEO), вам просто нужно скопировать и вставить URL-адрес вашей карты сайта и Better Robots.txt добавит его в ваш WordPress Robots.txt.

2. Защитите свои данные и контент

Не позволяйте вредоносным ботам сканировать ваш веб-сайт и коммерциализировать ваши данные.

Плагин Better Robots.txt помогает заблокировать сканирование и очистку ваших данных наиболее популярными вредоносными ботами.

Когда дело доходит до сканирования вашего сайта, есть хорошие и плохие боты. Хорошие боты, такие как бот Google, сканируют ваш сайт, чтобы проиндексировать его для поисковых систем. Другие сканируют ваш сайт по более гнусным причинам, таким как удаление вашего контента (текст, цена и т. Д.)) для переиздания, загрузки целых архивов вашего сайта или извлечения ваших изображений. Сообщалось, что некоторые боты даже закрывали целые веб-сайты в результате интенсивного использования широкополосного доступа.